Médico acusado de ter milhares de imagens de pornografia infantil no iCloud

A Apple revelou recentemente que vai implementar alguns mecanismos nos seus sistemas operativos para combater a propagação da pornografia infantil. Contudo, o anúncio gerou alguma polémica, apesar da Apple já ter o sistema implementado no iCloud. Ora foi exatamente neste serviço que foram detetadas mais de 2 mil imagens e vídeos de exploração sexual de crianças.

O Departamento de Justiça dos EUA acusou um médico de São Francisco da posse deste material ilícito.

Pornografia infantil encontrada no iCloud

No meio da polémica gerada em torno do sistema de deteção CSAM da Apple, um médico de São Francisco foi acusado de posse de pornografia infantil na sua conta do Apple iCloud, de acordo com autoridades federais.

O Departamento de Justiça dos EUA anunciou na quinta-feira que Andrew Mollick, de 58 anos, tinha pelo menos 2.000 imagens e vídeos de exploração sexual de crianças armazenados na sua conta do iCloud.

Mollick é um especialista em oncologia afiliado a vários médicos da Bay Area. Além disso, é também professor da UCSF School of Medicine.

Segundo a investigação, o médico carregou uma das imagens na aplicação da rede social Kik, conforme a queixa federal recentemente aberta.

Apple não quer material ilícito no seu ecossistema

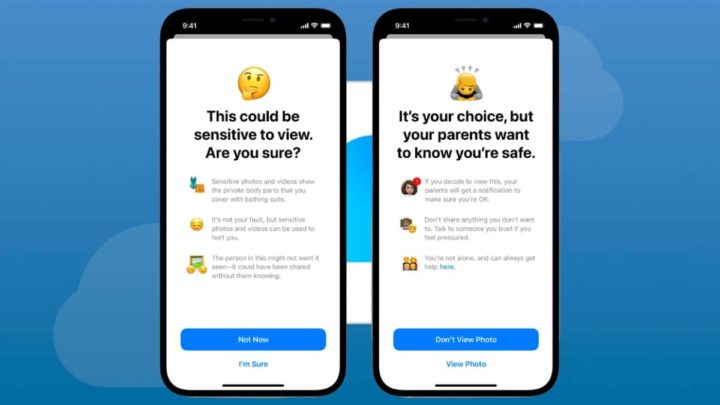

A Apple anunciou recentemente planos para introduzir um sistema projetado para detetar material de abuso sexual infantil (CSAM) no iCloud e fornecer um relatório ao Centro Nacional para Crianças Desaparecidas e Exploradas (NCMEC).

O sistema, que conta com técnicas criptográficas para garantir a privacidade do utilizador, tem gerado polémica entre as comunidades de direitos digitais e cibersegurança.

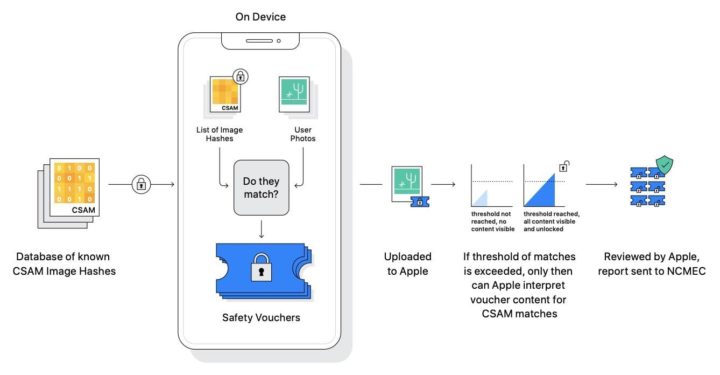

O sistema não verifica as imagens reais da conta iCloud de um utilizador. Em vez disso, ele baseia-se na correspondência de hashes de imagens armazenadas no iCloud com hashes CSAM fornecidos por pelo menos duas organizações de segurança infantil.

Também há um limite de pelo menos 30 peças de CSAM para ajudar a mitigar falsos positivos.

Sistema CSAM no iPhone, iPad e Mac vai avançar

Documentos revelados durante o julgamento Epic Games vs Apple indicavam que o chefe anti-fraude da Apple Eric Friedman pensava que os serviços da empresa de Cupertino eram a "maior plataforma de distribuição" da CSAM. Friedman atribuiu este facto à forte posição da Apple sobre a privacidade dos utilizadores.

Apesar da reação, a Apple avança com os seus planos para lançar o sistema de deteção CSAM. A gigante de Cupertino afirma que a plataforma ainda preservará a privacidade dos utilizadores que não possuem coleções de CSAM nas suas contas do iCloud.

Este artigo tem mais de um ano

Que vergonha !! Um médico com 58 anos.Eu até tinha nojo na cara.Infelizmente neste mundo o que não falta são tipos destes completamente desequilibrados da cabeça. “Andrew Mollick, de 58 anos, tinha pelo menos 2.000 imagens e vídeos de exploração sexual de crianças armazenados na sua conta do iCloud.” Inacreditável.

E formatarem a mente das crianças para que achem normal andarem a meter a chouriça no pacote já há que respeitar

E depois há os que defendem a privacidade….

Quem não deve não teme.

Eu só li não é da minha autoria:

“Who Should Not Fear, say the ignorant in an attempt to make others ignorant. This is only for those, who want to put on the cap, felt offended, it’s because the cap fit him.”

Jeanette Karen

Concordo cnt por isso recomendo que dormas com a porta aberta, não feches o carro e já agora podes me dar o teu numero de conta e acessos?

Só para verificar se tens alguma coisa ilícita, quem não deve não teme!

Posso instalar uma camera em tua casa? Já agora manda aí os logins de acesso das tuas contas cloud sff para ver se está tudo bem. Obrigado

Mas se calhar se a polícia for a tua casa perguntas pelo mandato…

Lá vai o sr.dr. dizer que uns tinham uma verruga na gland e prepúcio, a outra um sinal na Gina e lábios internos e outra ainda dois cravos no esfíncter…e por aí fora…

Mas se fosse um/a sexóloga ou médica fornece talvez já poderia ter essa colecção ou arquivo…talvez, talvez …

Bem , até ao fim do julgamento o homem não é culpado de nada …

Pode até ter sido vítima informática …

Logo se verá como acaba a história.

“Bem , até ao fim do julgamento o homem não é culpado de nada …

Pode até ter sido vítima informática …

Logo se verá como acaba a história.” Como ?? Eu acho que não sou deste mundo,só pode.Mas que é isto ??

Compreendo a sua indignação, mas o que o “.” escrevo está correto.

Todos nós sabemos o que é o lodo noticioso deste e de outros tipos de casos que mexem com o sentimento das pessoas. Nos USA é é muito frequente e, infelizmente, em Portugal também começa a ser.

Não conheço o médico nem em caso em apreço mas, até prova em contrário (é um preceito jurídico que os Taliban odeiam) o fulano está inocente. Goste-se ou não…

A Apple quer ter acesso total aos dispositivos e serviços complementares aderidos pelos utilizadores, então o novo sistema deles foi o pretexto para invadir ainda mais a privacidade dos utilizadores.

Eles só precisavam de uma controvérsia para sensibilizar as pessoas às novas políticas deles.

Eu não sou a favor do abuso de menores, mas a Apple é a Apple e marketing é o nome do meio da empresa.

Eu também acho o timing disto tudo curioso.

+1

Tudo dito.

Quando forem a investigar em profundidade vão encontrar 2000 fotografias de imagens de IMR com contraste de crianças com cancro.

Que fazem parte das base de dados das autoridades… e foram mostradas em tribunal!!! não digas disparates. Vai apanhar 20 anos de prisão e tu estás a tentar desculpar o criminoso?

Era o boost que a tecnologia precisava para ter aceitação publica. Com esta “noticia” deixa de ser polémico o uso da tecnologia. O poder do marketing e de influencia de massas é brutal e muito subestimado.

Encriptem as coisas antes de mandarem para a Cloud!

O homem, a ser pedófilo, merecia prisão perpétua no mínimo, mas o sistema de detecção em si é uma autêntica charlatanice e tanto havia para dizer sobre isso.

Fica aqui um link só como exemplo, que qualquer um pode experimentar.

https://github.com/anishathalye/neural-hash-collider

Que não tem nada a ver. Até porque tem de haver uma confirmação com as base de dados das autoridades e entidades de ptotrà criança. Nada a ver com o exemplo.

Queres um desenho é isso?

Ainda bem que há tantos preocupados com a “privacidade” e a cagarem-se para as crianças. Não devem ser pais, mas um dia podem vir a ser.

As criancas sao e devem ser protegidas. Agora usarem esse argumento para verifcarem todas as tuas fotos e emails e etc é que nao. Estao a ficar piores que o google e o facebook.

Para os que falam de privacidade e que nao tem problemas com a nuvem, eu ofereco contas de email de borla com 10gb cada no meu servidor pessoal. Fico a espera dos fortes. E ja agora utilizem o email para trocar informacao com o banco. Mas o meu servidor é seguro. Eu nao acedo a nada.

O assunto não é para rir mas dá vontade de rir a tão propalada e vendida privacidade da Apple eheheh