Como funciona o novo sistema da Apple para verificação de conteúdo de pornografia infantil

A Apple revelou ontem uma série de três medidas destinadas a proteger as crianças de várias maneiras. Um sistema triplo de mais informações através da Siri, uma monitorização do conteúdo do iCloud Fotografias para detetar pornografia infantil e um sistema de prevenção contra imagens explícitas na app Mensagens (iMessage) para utilizadores menores de 13 anos.

Estas medidas chegarão com iOS 15, iPadOS 15 e macOS 12 Monterey e vão ampliar as proteções para crianças sempre com total respeito pela privacidade de todos os dados. Então, como vai funcionar a verificação nas aplicações referidas?

Apple aplica medidas no combate à pornografia infantil

A Apple deixou 3 medidas e vamos explicar com mais detalhe como vão funcionar. Sobretudo, vamos entender como funciona a deteção de imagens de menores nas fotos do iCloud e as medidas de segurança da app Mensagens (iMessage) contra fotos explícitas.

As tecnologias visam a privacidade dos utilizadores, mas, sobretudo, a proteção dos menores.

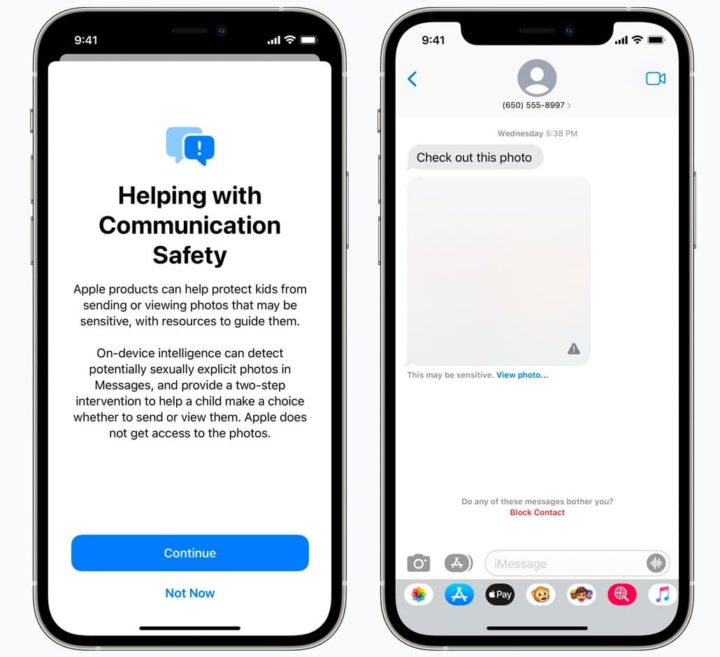

1 - Segurança na comunicação de Mensagens

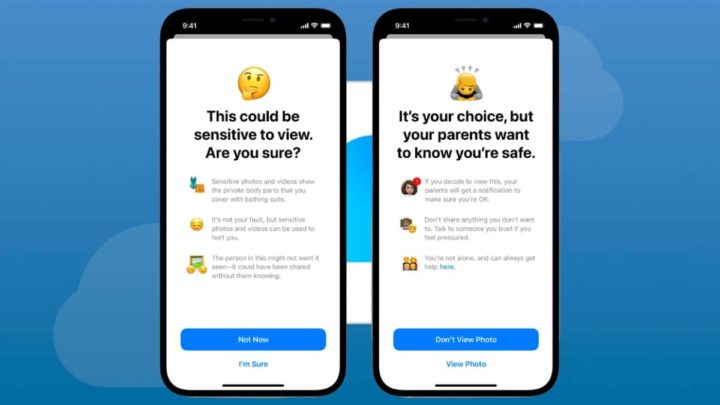

Conforme refere a Apple no seu site, o novo sistema de segurança de comunicações iMessage detetará e bloqueará imagens explícitas recebidas em conversas de crianças menores de 13 anos.

Esta é uma configuração opcional que os pais podem ajustar se desejarem e cuidará de ocultar as imagens inadequadas das conversas.

No entanto, a criança terá a opção de ver a imagem. O sistema atua ocultando a imagem e se esta for clicada a criança recebe uma mensagem a alertar que tal imagem pode ser sensível e explica a situação em três pontos:

- que as fotos sensíveis mostram partes do corpo que estão cobertas por fato de banho/roupa interior;

- que essas imagens podem ser usadas para prejudicar a sensibilidade;

- que a pessoa que aparece neles pode não querer ser vista.

Após esta explicação, o sistema permite à criança clicar nas opções "Agora não" ou "Tenho certeza".

Ao clicar na segunda opção, o sistema avisa que os pais "querem ter a certeza de que está bem", pelo que receberão uma notificação.

Também alerta a criança para não partilhar nada que não queira mesmo partilhar e para falar com alguém em quem confie se se sentir pressionada, e finalmente, oferece ajuda, afirmando que não está sozinha em certas situações. Depois oferece "Não ver a foto" ou "Ver a foto".

Conforme referimos, este sistema está concebido apenas para crianças menores de 13 anos, desde que os seus pais o considerem apropriado para o ativar.

A forma como a informação é comunicada, embora na língua das crianças, é muito clara e revela uma operação muito simples: se uma imagem explícita for detetada, é bloqueada, é dada a opção de escolher e os pais são avisados se for vista.

Este sistema funciona graças à aprendizagem automática no próprio dispositivo que analisa as imagens recebidas e também enviadas através do iMessage para apresentar avisos apropriados. Uma vez que todo o processamento ocorre localmente no dispositivo, ninguém, nem mesmo a Apple, tem acesso às mensagens, mantendo a segurança da app Mensagens em que confiamos.

2 - Deteção de imagens de menores no iCloud

A outra medida que a Apple irá implementar é a deteção de imagens de menores de idade em bibliotecas de fotografia no iCloud. Um sistema que, mantendo a privacidade de todos os utilizadores, permitirá informar os organismos competentes caso sejam detetadas imagens que violem a lei. Como, por exemplo, pornografia infantil, entre outros abusos a crianças.

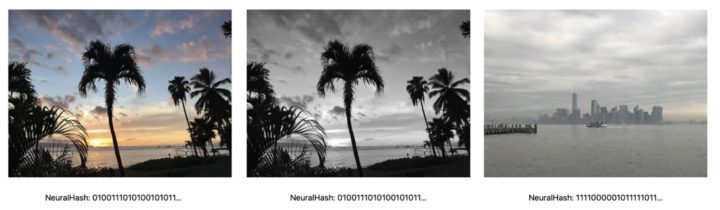

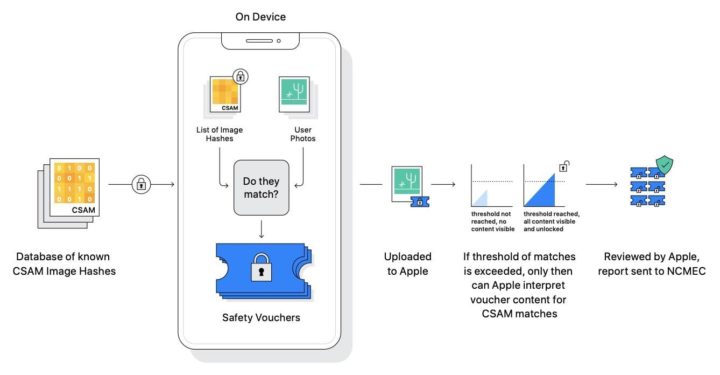

Em vez de monitorizar as imagens na cloud, com a consequente deterioração da privacidade, a Apple propõe um sistema que compara imagens de dispositivos com uma base de dados local. Esta base de dados é armazenada de forma segura no dispositivo e contém versões em hash das imagens relatadas pelas agências responsáveis, de modo a que o seu conteúdo seja completamente ilegível.

Estes hashes são concebidos de tal forma que não só representam a imagem original, mas também permitem variações da imagem original, tais como transformar a imagem em preto e branco ou cortar partes da mesma. Desta forma, versões da mesma imagem podem ser detetadas.

O sistema funciona de tal forma bem que antes de uma imagem ser carregada no iCloud Fotografias o dispositivo gera um hash da imagem e compara-a localmente com hashes de imagem relatados. O resultado desta verificação é ilegível a partir do dispositivo, em vez de ser aí analisado, o sistema envia um vouchers encriptado que é carregado para iCloud Fotografias junto com a imagem.

Então, é aqui que entra em jogo outra tecnologia, chamada threshold shared secretcy. Simplificando, a chave para decifrar o conteúdo dos vouchers cifrados é dividida em X fragmentos. Quando existem vouchers suficientes numa conta, a Apple recebe todos os pedaços da chave completa e pode decifrar o conteúdo destes vouchers, com as imagens que foram carregadas, revendo-as manualmente.

O limiar do voucher é estabelecido de forma a garantir que existe apenas uma hipótese em mil milhões por ano de marcar incorretamente determinado conteúdo.

Uma vez ultrapassado o limiar do voucher, a Apple recebe um relatório que pode decifrar e verificar manualmente. Se for confirmado que as imagens carregadas correspondem às da base de dados, a Apple suspende a conta e informa as autoridades. No entanto, oferece um sistema de recurso para restabelecer a conta se o utilizador considerar que foi cometido um erro.

Este mecanismo, que funcionará enquanto o dispositivo tiver o iCloud Fotografias ativado, foi concebido para proteger totalmente a nossa privacidade e, ao mesmo tempo, permitir-nos detetar imagens ilegais no sistema.

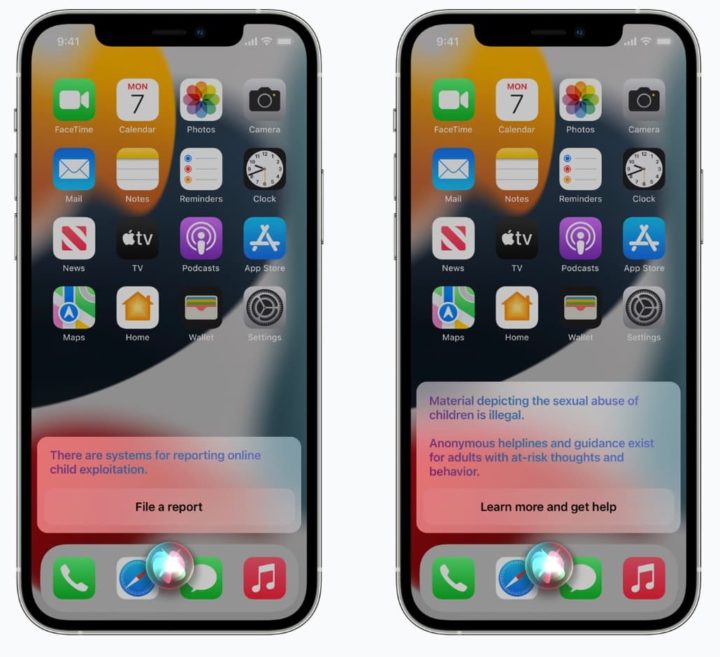

3 - Expandir a orientação na Siri e na Pesquisa

Por último, mas não menos importante, a Apple também está a expandir a orientação na Siri e na Pesquisa, fornecendo recursos adicionais para ajudar crianças e pais a se manterem seguros online e obter ajuda em situações inseguras.

Por exemplo, os utilizadores que perguntam à Siri como podem relatar Material de Abuso Sexual Infantil (CSAM) ou exploração infantil serão direcionados a recursos sobre onde e como registar uma denúncia.

A Siri e a Pesquisa também estão a ser atualizadas para intervir quando os utilizadores realizam pesquisas para consultas relacionadas ao CSAM. Estas intervenções irão explicar aos utilizadores que o interesse neste tópico é prejudicial e problemático, fornecendo recursos de parceiros para obter ajuda sobre este assunto.

Estas atualizações para a Siri e Pesquisa serão lançadas no final deste ano numa atualização para iOS 15, iPadOS 15, watchOS 8 e macOS Monterey.

Em resumo, estas novas ferramentas nos mais recentes sistemas operativos da Apple visam combater a pornografia infantil e outros atos abusivos perpetrados às crianças.

Este artigo tem mais de um ano

Bem imagino a quantidade de crianças nuas que eles tiveram acesso para treinar o AI disto

Se percebi bem, as fotos recebidas não são necessariamente de crianças. Pode ser de qualquer pessoa. O sistema está é no telemóvel de um criança.

Mas sim a primeira coisa que me veio à cabeça foi a quantidade de fotos explícitas que os engenheiros da Apple tiveram de fornecer ao algoritmo

Não é por AI. É apenas um sistema de verificação de hashes. Existe uma base de dados de hashes de conteúdo deste, que depois é comparado.

Óbvio que alguém tem de marcar os fotografias, existe um processo para isso. Mas este processo não é AI. Daí nem haver risco de fotos que tu tires sejam marcadas por este sistema (a não ser que sejam mesmo explicitas e andes a espalhar pela net)

mesmo.. imagina pais partilharem fotos dos filhos por qualquer motivo

lol, então basta por um water mark ou alterar um pixel para a hash ser diferente, o sistema é mesmo um algoritmo de reconhecimento de imagem, dai usarem acelerador AI. De qualquer modo. presumo que haja já encomendas à Apple pela China para detectar fotos com imagens que contem cartazes como “liberdade”, “Tibete”, ou na Aábia Saudita cartazes “Igualdade”,etc etc. Afinal a Apple na China vendeu-se e tem lá os servidores do iCloud para que o Governo Chinês possa usar a informação para o que lhe convem. E na Europa não tarda vai ser igual, afinal.

+1

Só o primeiro caso de imagens explicitas no iMessage é que tem deteção por AI, mas são sistemas diferentes. O sistema de deteção de pornografia infantil é que já é só hashes mesmo.

Sim! Eu estava a responder relativamente ao iMessage 🙂

Mas obrigado pela explicação! 🙂

Se bem percebi, há zero AI. Isto é tudo feito com base em hashes de imagens conhecidas e confiscadas como pornografia infantil.

É feito um check só do hash vs o que tens no telemóvel.

Não é ilegal teres fotos dos teus filhos no banho, por exemplo. Uma IA ia falhar nisso de certeza… É preciso ler as notícias antes de comentar.

espero que a Google copie…

Não sei com tanto controlo o Google começa a ficar sem negócio.

A Google já o faz: https://support.google.com/transparencyreport/answer/10330933?hl=en

Eu não percebo muito, mas não acho que os pedófilos andem a enviar fotos de crianças uns aos outros via mensagem, nem as armazenem numa cloud qualquer…

As vezes aparecem noticias de pessoas que tem x fotos nos computadores e nos tlm. Talvez alguns que tenham conhecimento de tecnologias e isso, mas n tenho duvida q mtos usem as clouds dos tlm e q tem à mão

Sim, é verdade. Eu estava a pensar mais em pessoas com um envolvimento mais profundo, nomeadamente redes de pedofilia. Mas sim, tens razão.

Comecar a analisar fotos dos utilizadores abre caminho para tantas coisas potencialmente más… 1 e 3 são perfeitamente validos, o 2 pode ser uma caixa de pandora…

Concordo. No entanto olhando para a história e pensando bem, a Apple não é a primeira a fazer isto. Na realidade é capaz de ser uma das últimas grandes empresa a fazê-lo.

A Google faz o mesmo nas plataformas deles (https://support.google.com/transparencyreport/answer/10330933?hl=en).

Facebook e Microsoft também há muitos anos (antigo escritor da guardian que reportou – https://twitter.com/charlesarthur/status/1423363444754026499?ref_src=twsrc%5Etfw%7Ctwcamp%5Etweetembed%7Ctwterm%5E1423363444754026499%7Ctwgr%5E%7Ctwcon%5Es1_&ref_url=https%3A%2F%2Fwww.macrumors.com%2F2021%2F08%2F05%2Fsecurity-researchers-alarmed-apple-csam-plans%2F)

Aliás, a Apple já faz isto no iCloud desde o ano passado. A única coisa que vai mudar é que vai passar a ser um processo local, e não no iCloud (https://www.telegraph.co.uk/technology/2020/01/08/apple-scans-icloud-photos-check-child-abuse/)

E até hoje não existe nenhuma notícia, report, ou informação que mostra estes sistema anti CSAM a ser usados para mais do que foram desenhados.

Por isso, apesar de não concordar com o conceito em si, para já não vejo qualquer razão para achar que vá ser abusado.

Verifica hashes não fotos. São coisas diferentes.

Abc

As hashes sao verificadas no tlm. Quando detecta o tal treshold referido na noticia, as informacao é combinada e um operador na apple consegue reconstruir a foto e analisar. Nao faz sentido avisar a policia com provas de que uma AI reconheceu qq coisa num sitio e não se pode verificar. O problema sao os falsos positivos…

Espero que sim @jlxpmme

O que deviam fazer era publicarem os modelos e o codigo que usam, e assim estava aberto a escrutinio publico. Aí quem percebia do assunto poderia verificar. Digo isto para qq uma das empresas referidas.

Não percebeste.

O que a notícia diz é que o hashing algorithm (não tem nada a ver com IA ou imagens) que no final gera uma string do estilo ASFHQWGFQUIWGDQP12!DAS!”#”!!DASE!”# para cada imagem é resiliente a pequenas alterações na imagem. Tudo é feito localmente.

O único “problema” destas imagens é que hash algorithms têm colisões (daí haver “1 hipótese em mil milhões por ano” de acontecer.

Existe então uma hipótese muito ínfima de imagens detectadas serem enviadas para a apple para verificação, do que percebi, se passares um threshould. Portanto, um falso positivo não te faz falhar, vários falsos positivos faz.

Seja como for, vocês não fazem mesmo ideia do que já acontece em ISPs e afins em Portugal. Se andarem a fazer o que não devem já estão a ser monitorizados. O que a apple faz é infinitamente menos invasivo (:

Exato @David. Muita gente não faz ideia. Aliás, o facto de isto estar a ser o escândalo que é para tanta gente mostra que muita gente não tinha noção mesmo. Aparentemente a maioria nem sabiam que as outras empresas como Google, Facebook e Microsoft já o faziam há muitos mais anos.

Mas só quando a Apple decidiu fazer o mesmo é que começou a polémica e a conversa de privacidade e “quanto tempo até regimes como china ou outros países usarem isto para o mal, como apanharem pessoas que partilham imagens que não gostam simplesmente?”

O esquema de hashing da apple eh baseado em AI. Chama-se Neural Hash. Tem tudo a ver com AI, mas ignorando esse parte. O resto tens razao. Eh match de hashes, pensava que eles conseguiam recuperar, mas so faz match com imagens ja existentes. Nao detecta coisas novas.

Eeeee uma coisa sao os ISP e basicamente man in the middle. Ou seja a partir do momento q as comunicacoes n forem cifradas quando saem do dispositivo, qq pessoa no meio pode potencialmente ver o que esta la. Outra coisa eh o que a Apple faz, que eh directamente no dispositivo. Sao pontos de acesso muito diferentes. Mas tal como dizes, isto eh bastante menos invasivo pq so faz match de padroes. Nao envia nada para eles. Retiro o que disse antes. :3

Como isto são comparação de hashes este sistema par combater CSAM não usa qualquer AI(ponto 1 usa AI, o ponto 2 não). O sistema é brutalmente simples, é apenas uma base de dados de hashes de fotografias que são consideradas pornografia infantil, que é usada para comparar com as hashes das tuas fotos. São simples comparações de texto. Desta forma nunca vai haver um falso positivo com as tuas fotos, e ninguém consegue ver o conteúdo das tuas fotos. Talvez seja possível haver colisão de hashes, mas a probabilidade é ridiculamente pequena e é por isso que existe depois o tal threshold, sendo assim preciso identificar várias fotos para o sistema ser alertado

Apesar ser uma ótima medida. Isto levanta outras questões, como a privacidade das tuas imagens…para uma empresa que autointitula super segura e respeita a privacidade.. Lol está tecnologia vai simplesmente analisar todas a tuas fotos, ou seja privacidade zero, para elem de que…te limita na tua liberdade de tirar fotos aos teus filhos nus… Sim, quem é que não tem aquela bela foto de pequeno todo nu na praia ou na piscina?

Já não posso tirar aos meus filhos igual?

Uma coisa é pedofilia, pornografia infantil (completamente contra) ,outra é recordar é viver..

Mais uma vez,se vê que a Apple é como Google Windows Facebook ou ainda pior… Porque cada vez mais cria maneiras de só ser ela a coletar os dados em nome da segurança lol como a música diz: “o golpe está aí, cai quem quer”

Não percebeste nada pois não ?

Lê ao artigo de novo que até explica razoavelmente bem.

Faltou também dizer que é uma opção que tem que ser ligada.

ABC

Nope. As tuas fotos não vão para lado nenhum e ninguém as vê, a não ser que tenhas fotos no iCloud e a polícia tenha uma mandato, aí podem aceder às tuas fotos.

Este sistema cria uma hash de uma foto(uma representação em texto da imagem, da qual é impossível reverter e saber o conteudo da imagem) e comparam com hashes de uma base de dados que contém hashes de imagens de pornografia infantil. Ou seja o sistema só faz uma simples comparação de texto. Esta comparação das hashes é feito no telemóvel(apenas se tiveres iCloud ativo). Portanto para resumir:

As tuas fotos não são carregadas para lado nenhum – apenas iCloud caso queiras

Ninguém consegue ver as tuas fotos para além de ti – e só com um mandato é que poderão aceder a fotos que tenhas no iCloud(irrelevante neste contexto pois sempre se aplicou)

Ninguém consegue saber o conteudo das tuas fotos com estas hashes

As fotos que tu tiras nunca irão alertar este sistema, a não ser que seja pornografia infantil que tenhas publicado na internet e que eventualmente seja carregado para a tal base de dados

Podes desativar por completo isto ao desativar backup de fotos para iCloud

BTW, essas empresas de que falas, Google, Facebook e Microsoft têm este sistema há anos e nunca foi abusado. Google desde 2008 (antigo escritor da guardian que reportou – https://twitter.com/charlesarthur/status/1423363444754026499?ref_src=twsrc%5Etfw%7Ctwcamp%5Etweetembed%7Ctwterm%5E1423363444754026499%7Ctwgr%5E%7Ctwcon%5Es1_&ref_url=https%3A%2F%2Fwww.macrumors.com%2F2021%2F08%2F05%2Fsecurity-researchers-alarmed-apple-csam-plans%2F)

hashes ou fotos completas não têm que scanar nada nos meus dispositivos.

estranho, não vejo nenhuma empresa a vir a tua casa ver se tens coisas que não é suposto sem forças de autoridade ou mandato judicial…

Além de que, ao contrário do que dizem aqui, não são hashes criptográficas, são hashes que são geradas de forma a lidar com degradações e mudanças nas imagens como resizes e compressões, pelo que as colisões e falsos positivos são bastante frequentes e by design.

” uma hipótese em mil milhões por ano”.

Não são bastante frequentes. São muito pouco frequentes. E se leres a notícia vês que não basta uma imagem. É preciso passares um certo threshould, ou seja, precisas de ter várias imagens apanhadas.

Temos 31536000 segundos por ano. Tinhas que tirar mais ou menos 31 fotografias por segundo no teu iphone para teres 1000000000. Mesmo assim, suponho que teriam que ser todas diferentes. Isto para teres uma hipótese de te descobrirem uma image.

Agora imagina teres que ter várias para seres considerado para uma review manual (que mesmo assim não te está a condenar) por teres tido várias imagens que bateram na base de dados de hashes de imagens já existentes. Eu diria que é praticamente impossível a não ser que andes a importar pornografia infantil para o teu telemóvel 😉

Toda esta raiva advém de pessoas que leram o título e não fizeram as contas nem perceberam o sistema.