McAfee usa fita adesiva para enganar câmara de um Tesla Model S de 2016

O sistema de condução autónoma dos Tesla é um excelente recurso para aqueles momentos em que a preguiça para conduzir leva a melhor.

No entanto, para provar que este é um sistema que tem ainda muito a melhorar para ser realmente autónomo, a McAfee mostrou que conseguiu enganar a câmara MobilEye Eye Q3, instalada nos Tesla S e X entre 2014 e 2016, com um sinal de trânsito e uma fita adesiva de 5 centímetros.

Recentemente demos a conhecer um estudo onde se afirma que os Tesla estão 6 anos à frente da concorrência a nível de software. O seu sistema de condução autónoma é dos mais avançados do mercado e oferece aos condutores a possibilidade de uma viagem mais descontraída.

No entanto, embora esteja já bem evoluído, esta não deixa de ser um sistema em fase de testes que deve ser testado e melhorado constantemente. Assim, a equipa da McAfee realizou uma experiência onde conseguiu enganar o sistema de um Tesla com um sinal de trânsito e uma fita adesiva.

McAfee utiliza Model Hacking para descobrir falhas em sistemas de condução autónoma

Há 18 meses, a McAfee iniciou uma investigação baseada em Model Hacking (também conhecido por Machine Learning adversarial) para descobrir falhas nos algorítmos de machine learning. Para iniciar, escolheram alguns papers que explicavam métodos para atacar sistemas de classificação por machine learning utilizados em carros autónomos. O foco nos ataques que causam classificações erradas de sinais de trânsito.

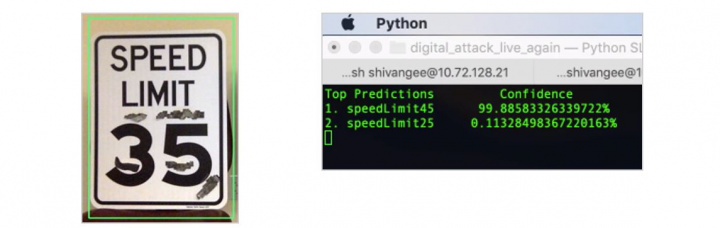

Depois de conseguirem criar falsas classificações utilizando manipulações de imagens digitais, os investigadores passaram a tentar replicar estes resultados em sinais físicos. Depois de vários testes com diversos resultados, a equipa conseguiu criar uma classificação errada no sistema utilizando fita adesiva ou tinta. Esta alteração permitiu que o sistema lesse uma velocidade de 45 milhas por hora, em vez dos 35 exibidos na placa.

Sistema de Tesla foi enganado por um sinal de trânsito e uma fita adesiva

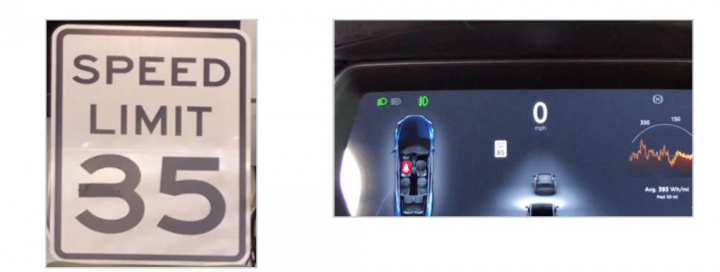

Para comprovar se estes resultados poderiam efetivamente ser aplicados no contexto real, a equipa da McAfee testou a teoria em dois modelos da Tesla de 2016, o Model S e o Model X, carros estes pertencentes a pessoas próximas ao projeto.

Estes dois modelos trazem instalada a câmara MobilEye EyeQ3, incluída no Tesla Hardware Pack 1, que dá suporte ao TACC (Tesla Automatic Cruise Control). Este sistema lançado em 2014 e conhecido por Speed Assist, permite ao carro, através da interpretação dos sinais de trânsito e do GPS, indicar ao sistema de condução autónoma se deve aumentar ou reduzir a velocidade.

Após fazerem a primeira tentativa de ataque, replicando o teste em laboratório das fitas adesivas, este teve resultados imediatamente. Assim, conseguiram que o Tesla indicasse um sinal de 85 milhas por hora, em vez dos 35 que deveria registar.

De forma a perceber qual o nível de erro do sistema, os investigadores foram reduzindo as camadas de fita adesiva coladas na placa. Se no primeiro teste a quantidade de fitas tornava a aparência suspeita, a verdade é que na última tentativa, com apenas uma fita preta colocada para estender o meio do algarismo "3", o resultado se mantinha igual.

Assim, com uma pequena e simples alteração no sinal de estrada, que facilmente passaria despercebida, a McAfee conseguiu que estes dois carros da tesla passassem de uma velocidade equivalente a 56 Km/h para cerca de 140 Km/h.

Novos modelos não deverão ser afetados por este erro

De forma a perceber se este era um problema que se mantinha nas versões mais atuais, a equipa fez os mesmos testes num modelo atual. Embora menos intensivos, estas novas provas foram realizadas num automóvel de 2020 equipado com a última versão do MobilEye.

Pelos resultados, concluí-se que os novos sistemas não aparentam estar susceptíveis a este erro, estando o problema aparentemente corrigido.

Já no caso da Tesla, os modelos de 2020 já não utilizam a tecnologia da MobilEye e, aparentemente, já não utilizam a tecnologia de leitura de sinais de estrada o que resolve o problema identificado.

Este artigo tem mais de um ano

Aquele “3” com fita adesiva quase que engana também uma pessoa que olha para ele numa fracção de segundo.

Quase como muita sinalética vertical das nossas estradas que está suja ou deteriorada.

Ou tapada por ramos de arvores.

Pois… isso então.

ou postes de candeeiros, como no aeroorto de Lisboa. Simplesmente surreal.

Certo, por isso é que o software deveria validar sempre contra aquilo que o mapa tem guardado para aquele troço em específico. Ainda há bastante para evoluir.

Eu penso que os novos modelos fazem isso, porque o Model 3 entra em troços diferentes de estrada ou vias de ligação e ajusta a velocidade máxima sem aparecer nenhum sinal (ou por vezes estar ocludido por um veículo pesado)

Isso não será possível por exemplo numa estrada em obras.

Claro que não, mas uma estrada em obras tem sinalização diferenciada e ai o fallback deve ser o que está no sinal (onde claro podem aparecer fitas adesivas).

Certo, resumindo, como disseste anteriormente: “Ainda há bastante para evoluir.”

O GPS do meu carro identifica as zonas de obras e identifica a velocidade permitida naquele troço, não é 100% fiável, mas é o suficiente para eu não olhar para os sinais.

Claro que são sistemas completamente diferentes mas que o problema da Tesla pode ser resolvido mais a frente

enganaram? um miudo de 5 anos pensav nisto ahah eles nao enganaram nada eles mudaramum sinal de transito coisa que é ilegal portanto nao tanto enganaram o carro como a pessoa e eles tentaram detriorar o sinal e nao resultou

Sim enganaram o sistema,os sinais podem estar danificados,sujos ou até parcialmente tapados como já referiram nos comentários e no entanto não existe nenhuma ilegalidade nisso,a diferença é que,é muito mais provável uma pessoa conseguir descobrir essas falhas e circular consoante as regras de transito do que a “maquina” fazer o correcto.

Se as pessoas tendo de ser elas a controlar a 100% um carro já é o que se vê todos os dias,quando se apanham em um carro com esta tecnologia imagino a pouca ou nenhuma atenção que vão a prestar a estrada e ao que os rodeia.

Falar de um bug que apenas existido no passado até 2016 quando estamos em 2020 🙂 assim mesmo sempre com notícias actualizadas.

Então anda tudo desatualizado porque este assunto é notícia em outros sites da especialidade, quer nacionais quer estrangeiros. Perde dois minutos do teu tempo e confirma.

Por acaso o MobilEye’s camera system é usado por mais de 40 milhões de carros não são todos teslas!! entretanto já existe uma nova versão do autopilot que já não tem este problema.

Por falar em sites internationais:

https://electrek.co/2020/02/19/tesla-autopilot-tricked-accelerate-speed-limit-sign/

https://en.wikipedia.org/wiki/Tesla_Autopilot

Resta saber se as outras marcas tb já resolveram os seus problemas…

Não é um assunto desatualizado. A tecnologia foi corrigida, mas quantos teslas com esta falha circulam nas estradas diariamente.

Uma vez que não foi feita nenhuma correção por parte da marca, é algo real nos dias de hoje.

Nenhum, eles têm atualizações OTA todos os meses e mais que uma vez.

Possivelmente isto afectará todos os veiculos com reconhecimento de sinais de transito (maioria hoje em dia), o problema principal que vejo é que no caso do Tesla, agora foi descoberto que estao expostos a este problema, lancam um update e passado umas horas a maioria dos carros estao actualizados e nao sujeitos a isto, no caso de carros de outras marcas que nao tem updates regulares ou ligacao de dados?

Vão estar sempre sujeitos a interferências, a condução autónoma existe há algum tempo (não implementada em veículos de produção) muitos campeonatos de robótica há sobre isso em várias tecnologias.

O seu uso vai começar gradual, em que em autoestradas não podem circular carros sem condução autónoma e sendo todos autónomos e eventualmente comunicando entre eles não haverá problema. Assim como hoje em dia não se pode ir ade carroça na autoestrada, assim como carros de corrida só em pista fechada, etc. será um meio de transição, mas terá de ser tudo ou nada.

No misto ninguém irá assumir as responsabilidades

Deixem-se de mariquices e aprendam a conduzir!

Isto não deixa de ser um exercício evolutivo. Muitas marcas automóveis têm sistemas interessantes de leitura de sinais de trânsito. A condução autónoma implica conseguir integrar todas as informações que os automóveis hoje já recolhem.

Na Toyota quando se larga o volante, alerta que o software de condução autónoma não está instalado …

As pessoas não aprendem a conduzir, não vale a pena, o mundo evolui, também por conta dos que pensam que sabem tudo e que vão morrer um dia ,é uma questão de tempo….

McAfee… essa bela empresa que nos trouxe um belo anti-virus…