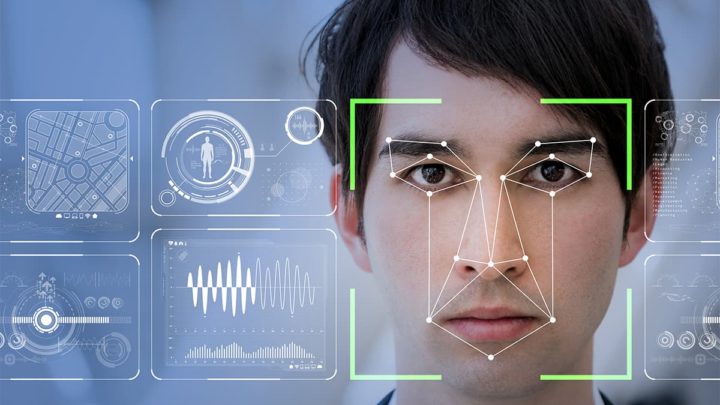

Especialista alerta: IA com preconceitos raciais pode levar a falsas detenções

A inteligência artificial (IA) com preconceitos raciais não só é enganadora, como também pode ser prejudicial, destruindo a vida das pessoas. É este o aviso que o professor assistente da Faculdade de Direito da Universidade de Alberta, Dr. Gideon Christian, fez num comunicado de imprensa da instituição.

Christian recebeu uma subvenção de 50.000 dólares do Office of the Privacy Commissioner Contributions Program para um projeto de investigação intitulado Mitigating Race, Gender and Privacy Impacts of AI Facial Recognition Technology.

A iniciativa tem por objetivo estudar as questões raciais na tecnologia de reconhecimento facial baseada na IA no Canadá. Christian é considerado um especialista em IA e direito.

Existe esta falsa noção de que a tecnologia, ao contrário dos humanos, não é tendenciosa. Isso não é exato.

Foi demonstrado que a tecnologia tem a capacidade de reproduzir o preconceito humano. Em algumas tecnologias de reconhecimento facial, a taxa de precisão no reconhecimento de rostos de homens brancos é superior a 99 %.

Mas, infelizmente, quando se trata de reconhecer rostos de cor, especialmente os rostos de mulheres negras, a tecnologia parece manifestar a sua maior taxa de erro, que é de cerca de 35 %.

Explicou Christian, no comunicado de imprensa da instituição, acrescentando ainda que a tecnologia de reconhecimento facial pode fazer coincidir erradamente um rosto com o de outra pessoa que possa ter cometido um crime.

A culpa é apenas e só dos algoritmos de aprendizagem automática?

O que temos visto no Canadá são casos de mulheres negras, imigrantes que apresentaram com sucesso pedidos de asilo, a quem foi retirado o estatuto de refugiado com base no facto de a tecnologia de reconhecimento facial fazer corresponder o seu rosto ao de outra pessoa.

Assim, o governo argumenta que elas apresentaram pedidos usando identidades falsas. Mas, atenção, trata-se de mulheres negras - o mesmo grupo demográfico em que a IA tem a sua pior taxa de erro.

Disse o professor.

Christian explicou que a IA nunca é inerentemente tendenciosa, mas que a culpa é dos dados utilizados para treinar os algoritmos de aprendizagem automática. A tecnologia produzirá resultados de acordo com os dados que lhe são fornecidos.

Livre de preconceitos e discriminação racial na IA

A maioria de nós quer viver numa sociedade livre de preconceitos raciais e de discriminação.

É essa a essência da minha investigação, especificamente na área da IA. Não creio que queiramos uma situação em que o preconceito racial, que tanto nos esforçámos por resolver, esteja agora a ser subtilmente perpetuado pela tecnologia da IA.

Afirmou Christian.

O professor referiu que, em muitos aspetos, este é um problema antigo que se está a mascarar como uma questão nova. O professor avisou que, se não for abordado, pode destruir anos de progresso.

Leia também...

Este artigo tem mais de um ano

Deus nos livre se isto chegar a este ponto. 😐

A “culpa” é como a natureza funciona no espectro visual. Cores escuras reflectem menos energia que cores claras. Logo é muito mais dificil reconhecer detalhes identificadores numa pele escura que numa branca. Pois há mais contraste visual numa face branca – boca, sobrancelheas (menos nos louros), olhos- do que numa preta.

Já num idoso por exemplo com sobrancelhas cinzentas essa parte já será mais identificalvel se essa pessoas for preta do que se for branca.

Tecnologia que começou nos anos 50 em que as bases do reconhecimento de alvos é o contraste entre pixeis.

As duas únicas soluções para este problema é aumentar a resolução das cameras ou usar tecnologias de identificação fora do espectro visual onde a reflecção de energia que ilumina não conta.

Sim, mas os grandes ” líricos” entendidos que por aí andam não entendem que é somente uma questão técnica, e fazem extrapolações políticas mediáticas para o racismo. Hoje tudo é racismo. Vai chegar o dia em que respirar é racismo. Colocar características humanas em sistemas sintéticos como IA é de bradar aos céus. Não conseguem perceber que a IA é desprovida das nossas palermices mundanas, a não ser que seja programada para incluir. Mas se se programa uma IA a perceber os meandros da nossa sensibilidade nunca vai funcionar efectivamente como deveria pois não é um ser consciente e social. Nunca vai ser, não nasce, nem vive nem morre…. nem o skynet dos filmes é verdadeiramente um ser consciente da sua mortalidade:)

Acho que enquanto existirem Anti-Racistas, o racismo nunca vai acabar.

Enquanto houver policia, o crime nunca vai acabar! Es um filosofo!!!

Um dramaturgo Italiano Ennio Flaiano dizia que havia 2 tipos de fascistas: os fascistas e os anti-fascistas.

Nem mais! Um equipamento não faz julgamentos morais ou de preconceitos como estes senhores o dizem, por mais que nós digamos que existe ali “inteligência”! Apenas existem de facto limites factuais e cientificamente comprovados relativamente aos próprios equipamentos que os levam a errar. Um aparelho faz ligações de dados, imita sem intenção! Não deduz nada, nem sequer possuiu um sistema de valores. Apontar uma má ou deficiente leitura ao racismo, é demasiado elementar e até estupido, para dizer a verdade. Significa estamos demasiado confiantes que atingimos um grau de sofisticação que afinal não temos! Anda muita gente a ver demasiados filmes de ficção científica! Um investigador de boa-fé, não pode concluir, que por existirem erros de leitura de uma máquina, estes se devem a “preconceitos”! Isso é demasiado básico e até perigoso. As máquinas, mesmo quando se lhe pede para imitar um determinado artista, têm sempre limites relativamente aos dados que podem processar – um artista será sempre capaz de nos surpreender, uma máquina limita-se a dar aquilo que tem. Por mais sofisticada que seja. Ou seja, na realidade não tem criatividade alguma, algo que é inerente ao Ser Humano, pode aperfeiçoar um desenho devido dentro dos limites dos dados, esquemas matemáticos e lógicos que a fazem actuar, não irá além disso. Por exemplo quando pedimos a informação de um artista, irá registar o seu nome, datas em que o “pedido” foi feito e irá dar tudo o que tem na sua base de dados desse artista! O mesmo serve para restaurantes ou mesmo a identificação de uma flor, que se não estiver na base de dados a que tem acesso, ou não a “visualizar” como deve ser irá indicar-nos algo estapafúrdio! Quantas vezes isso não aconteceu? A mim várias vezes. Portanto, quando analisa a cor de pele de alguém devemos ter em conta essas limitações que referiu, que serão mais culpa do espectro de luz que pode analisar do que outra coisa. Arrogância humana na sua tecnologia tem dado imensos dissabores. Pede-se mais de bom-senso, isso, nenhuma máquina o irá dar. Pelo menos nos tempos mais próximos.

A AI utiliza dados existentes.

Se esses dados tendem para alguma raça em maioria, a culpa é da AI?

Adoro estes especialistas de sofá que nem deve saber o que está por trás da criação de uma IA e mandam teorias baseadas nas suas teorias sobre a teoria da IA.

Acho que nao percebeste mesmo nada, do que leste! Ele nao diz, que a maquina o faz. Ele alerta, que com os dados, algoritmos e tecnologia atuais, essa situaçao tb possa acontecer. Ou seja, os cidadaos negros, podem ter problemas e serem claramente prejudicados, se for usado o sistema de reconhecimento facial e IA, da mm forma que para nao negros. Se ha limitaçoes tecnicas e afins, que ainda n se conseguem resolver, entao o seu uso, tb deve ser adaptado e refletir isso mesmo. Ou tu, tb gostarias de ser confundido com um qq criminoso p ex? É que se as autoridades encornarem, teras uma carga de trabalhos pa te livrares delas. Todos sao apenas…humanos, mas com caracteristicas diferentes. Ja faz lembrar os famosos detetores de mentiras, que alguns organismos ate usam (nos est unidos ate nas agencias de segurança), mas que nao tem fiabilidade nenhuma e nunca foram validados nos tribunais (acho eu). Acho muito bem usarmos a tecnologia, mas ate ao limite do principio de Peter.

E a solução passa pelo quê? Encher os dados de pesquisa da IA de informação errada? Se é essa a solução mais vale estarem quietos. E também não estou a ver outra solução, uma vez que a IA precisa de dados. Se formos encher com informações erradas não vai servir absolutamente para nada.