IA da Microsoft pode simular a voz de qualquer pessoa com 3 segundos de áudio

Há muito receio relativo ao que poderá acontecer com a Inteligência Artificial (IA) disponível no quotidiano. Até que ponto esta nova tecnologia irá suplantar o ser humano e se poderá ser usada para fins maléficos e prejudiciais à humanidade. A verdade é que hoje a IA já surpreende. Depois de termos visto as capacidades do projeto ChatGPT, a Microsoft apresenta-nos agora o VALL-E. Este é um novo modelo de IA de conversão de texto em fala.

Depois de uma plataforma que é capaz de produzir textos como humanos, chega uma tecnologia que permite converter texto-para-fala conseguindo preservar o tom emocional e o ambiente acústico do orador.

Três segundos chegam para a IA aprender a imitar uma voz humana

Num artigo publicado pela Arstechnica, é revelado que, na quinta-feira passada, os investigadores da Microsoft anunciaram um novo modelo AI texto-para-fala chamado VALL-E que pode simular de perto a voz de uma pessoa quando lhe é dada uma amostra de áudio de três segundos.

Uma vez aprendida uma voz específica, VALL-E pode sintetizar áudio dessa pessoa dizendo qualquer coisa - e fazê-lo de uma forma que tente preservar o tom emocional do orador.

Os seus criadores especulam que o VALL-E poderá ser usado para aplicações de alta qualidade texto-fala, edição de fala onde uma gravação de uma pessoa poderia ser editada e alterada a partir de uma transcrição de texto (fazendo-os dizer algo que originalmente não diziam), e criação de conteúdo áudio quando combinado com outros modelos generativos de IA como o GPT-3.

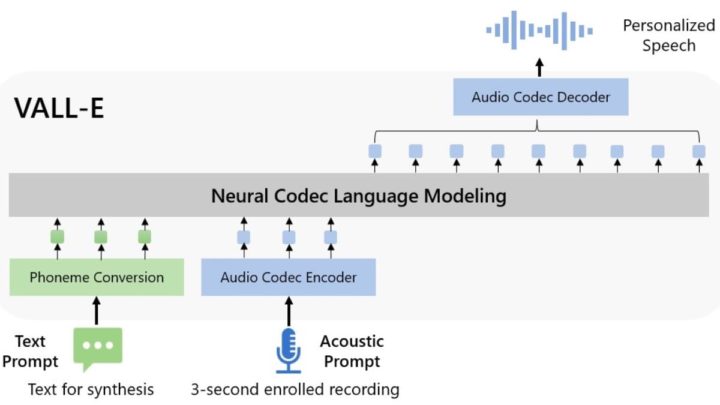

A Microsoft refere-se a esta plataforma como um "modelo de linguagem de codec neuronal". O VALL-E é baseado numa tecnologia chamada EnCodec, que a Meta anunciou em outubro de 2022.

Ao contrário de outros métodos texto-fala que tipicamente sintetizam a fala através da manipulação de formas de onda, o VALL-E gera códigos de codecs de áudio discretos a partir de mensagens de texto e acústicas. Analisa basicamente como uma pessoa soa, parte essa informação em componentes discretos (chamados "fichas") graças ao EnCodec, e utiliza dados de treino para corresponder ao que "sabe" sobre como essa voz soaria se falasse outras frases fora da amostra de três segundos.

Microsoft treina IA VALL-E com 60 mil horas de discurso

A Microsoft treinou as capacidades de síntese de fala do VALL-E numa biblioteca de áudio, montada pela Meta, chamada LibriLight.

Esta base de dados de áudio contém 60.000 horas de discurso em língua inglesa de mais de 7.000 falantes, a maior parte das quais obtidas dos audiolivros de domínio público da LibriVox. Para que VALL-E gere um bom resultado, a voz na amostra de três segundos deve corresponder de perto a uma voz nos dados de formação.

Segundo a ArsTechnica, no website VALL-E exemplo, a Microsoft fornece dezenas de exemplos de áudio do modelo AI em ação. Entre as amostras, o "Speaker Prompt" é o áudio de três segundos fornecido ao VALL-E que deve imitar.

Segundo a ArsTechnica, no website VALL-E exemplo, a Microsoft fornece dezenas de exemplos de áudio do modelo AI em ação. Entre as amostras, o "Speaker Prompt" é o áudio de três segundos fornecido ao VALL-E que deve imitar.

A "Ground Truth" é uma gravação pré-existente desse mesmo orador que diz uma frase específica para fins de comparação (como o "controlo" na experiência).

A "Baseline" é um exemplo de síntese fornecida por um método convencional de síntese texto-fala, e a amostra "VALL-E" é a saída do modelo VALL-E.

A curiosidade é a perspicácia e velocidade da tecnologia a aprender. Segundo informações, enquanto utilizavam VALL-E para gerar estes resultados, os investigadores apenas alimentaram a amostra de três segundos de "Speaker Prompt" e uma cadeia de texto (o que queriam que a voz dissesse) em VALL-E.

Se quiserem testar as evidências, comparem no site da plataforma a amostra "Ground Truth" com a amostra "VALL-E". Nalguns casos, as duas amostras estão muito próximas. Vários resultados VALL-E parecem gerados por computador, mas curiosamente há muitos outros que podem ser potencialmente confundidos com o discurso de um humano, que é o objetivo do modelo.

Este artigo tem mais de um ano

3 segundos ? Impossível, a minha voz varia ao longo do dia . De manhã rouca , outras vezes fraca , outras vezes forte….há muitas variações ao longo do dia que em 3 segundos são impossíveis de analisar..percebo a ideia , mas….

Sim e não. Apenas ia depender se os 3 segundos são com a tua voz “rouca, fraca ou forte”…

O discurso gerado ia ser de acordo com a amostra. Simples.

Ia não, vai depender! Esta tecnologia já existe, isto é uma variante da M$. Já andaram a fazer telefonemas para bancos com a “voz do chefe” a ordenar transferencias

Os problemas que a IA poderão trazer.

Pior que a Inteligência Artificial só mesmo a Burrice Natural 🙂

Isso para alguns fulanos produzirem “deepfakes” aliado a vídeos com face sawp… Ui ui!

Mas a maioria de sites text-to-speech com I.A, que eu conheço, têm limitações legais. Não aceitam ficheiros de áudio upload (voz de outra pessoa gravada), temos de ser nós em tempo real a gravar uma frase no microfone. E só aceitam idioma inglês, por enquanto.

Ou seja, por agora, não será “fácil” imitar a voz doutra pessoa.

Isso resolve-se facilmente com dispositivos virtuais que são vistos pelo sistema como microfone, mas cuja fonte pode ser um ficheiro de áudio.

O VoiceMeter, por exemplo, deverá permitir forjar um áudio desta forma.

Presumo que ao final de 3 segundos diga … “blue screen” 🙂

Impressionante!

Pergunto-me se não estaremos a chegar a um ponto de exagero, no que toca à IA… A tecnologia pode ser uma excelente ferramenta, mas pude acarretar demasiados problemas…

o timbre de voz até pode ser, mas o sotaque duvido muito..

Remembering Skynet… Parece que a realidade quer imitar a ficção… ou será que a ficção já se tornou a realidade??? Para aqueles mais cépticos, pensem só um pouco numa consequência mais “terra-a-terra”: piratas informáticos roubam os teus dados de voz, e depois vendem ou aplicam esses dados em esquemas de burlas ou roubos, utilizando a tua própria voz! Parece-me perfeitamente plausível!