Análises mostram que a gráfica RTX 3080 é mais rápida do que a RX 6800 XT

Estamos oficialmente perante uma interessante competição que põem à prova as novas placas gráficas das duas grandes fabricantes Nvidia e AMD. E, pelos comentários a vários artigos deste tema, percebemos que há defensores das duas marcas.

No entanto, de acordo com 17 diferentes análises, a GeForce RTX 3080 da Nvidia é mais rápida do que a Radeon RX 6800 XT da AMD.

A apresentação das novas gráficas da Nvidia e da AMD vieram 'alegrar' este segmento. E até mesmo os consumidores que não percebem ou não dão grande importância a este mercado, estão entusiasmados com estes produtos por serem verdadeiras máquinas no campo do hardware gráfico.

Relembramos que a Nvidia trouxe as placas GeForce RTX 3070, RTX 3080 e RTX 3090, enquanto que a AMD respondeu com as Radeon RX 6800, RX 6800 XT e RX 6900 XT. De salientar ainda que, para os nossos leitores, a Nvidia é a melhor fabricante de chips gráficos.

RX 6800 XT da AMD é mais lenta do que a RTX 3080 da Nvidia

No anúncio das novas placas da AMD, verificou-se que, pelas características, a Radeon RX 6800 XT iria competir diretamente com a GeForce RTx 3080 da Nvidia.

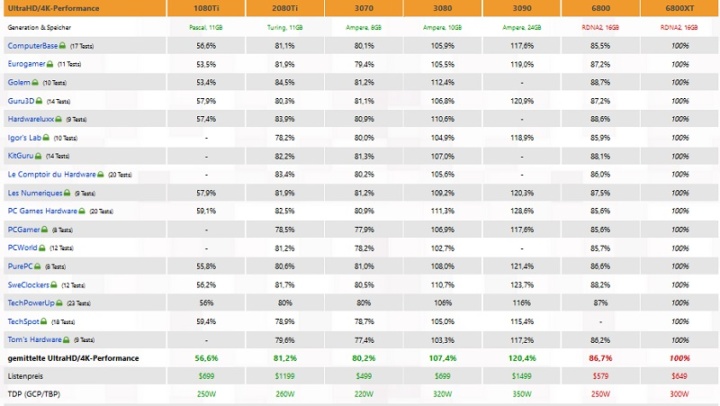

Nesse sentido, vários testes e análises já foram feitos e permitiram chegar a algumas conclusões. Os dados seguintes incluem 224 benchmarks de 17 análises internacionais realizadas por sites como Computer Base, Igor's Lab, Tom Hardware, PC Gamer e Guru3D.

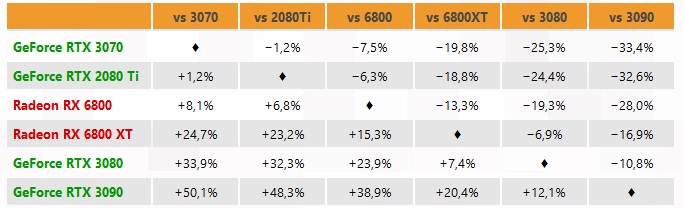

Segundo as análises realizadas às duas placas gráficas, a RTX 3080 da Nvidia apresenta um desempenho 7,4% superior ao da concorrente RX 6800 XT da AMD.

Segundo o site 3DCenter.org, estes resultados incluem somente testes feitos na resolução 4K (3840 x 2160 pixels). Para além disso não foi usado Ray Tracing ou Deep Learning Super Sampling (DLSS).

No que respeita à relação custo/desempenho, a RTX 3080 tem um custo de 699 dólares, enquanto que a RX 6800 XT custará 649 dólares. Ou seja, é uma diferença também de cerca de 7,4%.

Por sua vez, no frente a frente da Radeon RX 6800 com a GeForce RTX 3070, a placa da AMD fica à frente com um desempenho 8,1% superior em 4K. No entanto a placa da Nvidia é 15% mais barata, custando 499 dólares face aos 579 dólares da rival.

Leia também:

Este artigo tem mais de um ano

Fonte: 3DCenter

Neste artigo: AMD, gpu, nvidia, placa gráfica, RTX 3080, RX 6800 XT

Eu até compraria a 6800 face à 3070 (se houvesse stock). Porém o DLSS é algo fascinante…

Ganha a 4K, mas perde a 1080p e 1440p.

Para quem quer jogar com high refresh rate, as 6800 são a melhor escolha, por uma boa margem.

E para quem quer fazer renders rápidos com os RT cores a Nvidia é sem dúvida a escolha melhor (e única), pelo menos em v-ray no 3ds Max e em cycles no Blender.

Sim.E também para quem faz streamming.

Exacto ! Para a grande maioria ( que joga a 4 k ? ) são mais rápidas , melhor performance em jogos mais recentes e com 16Gb Ram devem durar / amadurecer melhor.

Sim, os 16Gb de vram poderá ser uma grande vantagem para as RX 6800.

Aqueles 8Gb da 3070 parecem muito curtos. E o mesmo para os 10Gb da 3080.

Estamos a começar um nova geração de consolas e os requisitos dos jogos vão subir, incluindo a vram necessária. Junta-se a isso os packs de texturas HD que muitos jogos no PC costuma receber.

Penso que a tecnologia do DLSS, ou outra do género, que venha a tornar-se padrão irá reduzir as necessidades de grandes quantidades de vram a curto/medio prazo.

Posso estar enganado, mas não seria melhor ideia terem optado por, por exemplo, 12gb de ram e fazer um pricing mais agressivo? Uma diferença de 50$ é insignificante para quem dá 650~700$ por uma placa gráfica, ninguém vai olhar a isso.

As diferenças de preço vs diferenças de de desempenho também andam ela por ela, aliando o RT + DLSS + streaming penso que a nvidia vai continuar confortável…

Sinceramente não acho que melhor desempenho a 1440p ou 1080p seja argumento numa placa deste preço, e os 16gb de ram perdem razão de ser quando a mesma é batida a 4K, é um contrassenso na minha opinião.

Artigo bastante biased.

As 6800XT dão pau nas 3080 quer em 1080p quer em 1440p, que é o que interessa para jogar em high refresh rates.. jogar a 4k ainda é um nicho de mercado, e para mais, há diferenças de preço nas gráficas versus diferença de fps a 4k.

Além de tudo isto pegar numa opinião de um único site e credibilizar é o que vale.. cartilheiros.

Faltou referir que as gráficas da amd ganham bastante quando emparelhadas com os ryzen por causa da SAM.

E nesse teste aleatório nem se percebe bem o setup que usaram, mas aposto que devem andar aí os 10k medíocres de 14nm da intel, convém mais para os lados da nvidia.

Sem dúvida! E falta ainda testar nos jogos mais recentes como Dirt5, AC Valhalla, etc. Aí as RX 6800 são até superiores à 3090 até sem SAM. Pelos vistos estes resultados parecem não interessar e agarram-se com unhas e dentes ao Ray Tracing (palhaçada). Este último só é aceitável com o DLSS ligado, que baixa a resolução e depois faz upscale, portanto um fake 4K!! Onde andam os puristas que exigem qualidade máxima na resolução?? Aceitam o DLSS que “Borra” a imagem??? Esperemos que a AMD optimize fortemente o Fidelity FX em 4K, que faz basicamente o mesmo, para calar a soberba da Nvidia.

A Intel já ficou para trás, a Nvidia está quase, apenas pendurada no DLSS.

Nota final, a maioria do MERCADO gaming joga a 1080p e 1440p, portanto as pessoas vão saber escolher. Assim de futuro veremos a inversão do market share em gaming GPU.

O dlss é como a porcaria que se passava com as televisões à uns anos atrás, enganavam os consumidores com artimanhas de software passando a ideia que os painéis eram de 100hz+ quando no fundo nem metade eram. Os super smooth modes e o raio.

O dlss é uma porcaria, e mal implementado em vez de melhorar a imagem vai piorar. Os drivers da amd ainda agora saíram, e com o tempo também vão melhorar, e sim, existe essa tecnologia da amd que é muito semelhante ao dlss.

Eu estou convencido de que com o amadurecimento dos drivers e de todas as tecnologias que foram implementadas nesta nova rdna as gráficas ainda melhor vão ficar. A sam é uma feature brilhante e faz diferença em algumas situações que já foram testadas, tanto é que a NVIDIA anda a tentar copiar isso.

Ninguém tem dúvidas que o combo AMD + AMD neste momento é mais vantajoso que Intel + AMD ou Intel + NVIDIA. Mais barato, mais capaz.

Os fanboys vão continuar a dizer que Intel e NVIDIA dominam, é lixado levar pau de uma empresa que para eles estava moribunda.. primeiro foi a Intel que ficou agarrada aos 14nm e dali não sai, e agora é a Intel que apressou tudo para tentar lançar as 3xxx na tentativa de impressionar porque já sabia o que vinha aí do lado da amd.

Não foi a Intel que apressou as 3xxx…quanto muito foi a nvidia.

E o dlss 2.0 está muito longe de ser uma porcaria,faz um trabalho excelente.

Uau que descoberta fenomenal que fizeste, é semelhante à descoberta da roda.

Obviamente que foi um mistype quando disse Intel, mas quando te faltam argumentos pegas nas tretas sem importância. Adiante. Post teu com zero conteúdo, zero argumentos.

E lamento, mas o dlss é uma m*rda aos meus olhos, e como eu trabalho na área, por muito que me tentes vender isso, não passa da tua opinião.

Se vires bem na ultima tabela são testes de 17 sites diferentes.

Isso é verdade mas a culpada é a AMD e não o artigo, a AMD sempre se referiu às 6800 para gaming em 4K uma vez que se o dissessem que era para jogar em 2K e ao preço que foram lançadas…iam-lhes cair em cima

Exatamente, jogar em 4K e não jogar em 4K + Ray Tracing. Em 4K são ótimas, a diferença é mínima, portanto cumprem plenamente o propósito. 1080p e 1440p “check”! Em RDNA3, se a Nvidia não se mexer, será o “mate”.

Acho curioso os que vêm defender a AMD com estas gráficas, quando a AMD tem pior:

– video (qualidade e codificação/ descodificador)

– performance em 4K (e o presente/ futuro é 4K, não é 1080p/1440p) é pior, e as TVs e bons monitores são 4K

– Ray-Tracing nada competidor

– DLSS não existente nos próximos tempos (e faz MUITA diferença, pode-se jogar em 4K e RT a altas velocidades com uma qualidade quase 4K real)

– mau para apps 3D profissionais, a maioria das apps profissionais usam CUDA

Portanto parece-me que a AMD anda a reinar nos CPU mas a relaxar muito nos GPU. 16 GB de VRAM é excelente mas só se trouxe velocidade. Ora, se a tecnologia da AMD é inferior, até podia ter 64 GB…

A conversa do 4k é o futuro já anda aí a circular aos anos, quanto mais em high refresh rate, vale muito mais o refresh rate que o bump de 1440p para 4k em gaming. O uso profissional que apontas é dúbio (é o meu uso e não uso nvidia) e dá-me muito mais jeito ter mais vram que ray tracing.

Quem é que mantém uma gráfica mais de 2 anos? Eu troco as minhas com mais regularidade que isso, a do pc de casa e da workstation de trabalho. Em casa tenho uma televisão 4k aos anos, mas não significa que me veja tão cedo a sair do high refresh rate a 1440p para jogar em 4k, e no trabalho onde tenho monitores 4k não jogo, obviamente, porque é uma estupidez.

Por isso vale o que vale a tua opinião.

E a 6800XT quando usada com um Ryzen ainda tem melhor performance 4k do que o apresentado nesse teste por causa do sam que a amiga nvidia também quer copiar.

Além de ser mais barata.

Peanuts

Não sei se usas gráficas para o trabalho de renderização 3D.

Eu uso,e digo-te uma coisa: 8GB de VRAM chegam perfeitamente para cenas 3ds Max + vray com várias dezenas de milhões de pixeis, e o vray rtx permite uma aceleração em média de 40% relativamente às que não têm esta tecnologia. Tempo é dinheiro…

Errata: em vez de pixeis quis dizer polígonos,obviamente.

Não, não chega, e como digo o ray tracing para mim profissionalmente é um peanut do tamanho de um barrete de inverno, e nada me vem trazer de interessante (não é que tenhas alguma coisa a haver com isso), ao contrário da vram a mais, e nem vem trazer a quem joga em 4k como vocês, os gajos das palas verdes apregoam, já que ray tracing com o todo poderoso dlss 2.0 ligado, e a gráfica ainda se borra toda para chegar aos 60fps em alguns jogos e com a vram quase a chegar ao limite e a não dar mais em alguns casos. Se me dissesses que metias a gráfica a 4k a 144Hz aí era outra conversa.

E iremos todos ver o que é que vai acontecer com alguns jogos a usarem texturas enormes, o FS2020 por exemplo chega com enorme facilidade aos 11 ou 12GB de vram. E não venhas com a conversa da porcaria do dlss porque embora baixe ligeiramente o consumo de vram não vai ter um impacto ao ponto de não estar capada por isso, nem tão pouco todos nós, os developers vamos implementar isso nos jogos/apps todos/as porque, mais uma vez, a nvidia parece a porcaria da apple com as coisas proprietárias, é os dlss’s, é os gsyncs, e afins.

Para finalizar, mais uma vez isso é a TUA opinião, é mais do mesmo como foi no post de cima com larachas sem conteúdo. É que ir ao google pesquisar as cenas da moda dos droids e vir para aqui fazer posts pseudo inteligentes não fazem de ti um génio.

Como disse em cima, não é que tenhas alguma coisa a haver com isso, mas os tais 8GB de vram para o que eu faço profissionalmente não me chegam nem pintados de ouro, já não estamos em 2014 para isso acontecer, mas se calhar agora queres também saber tu melhor disso porque coitada da nvidia só conseguiu enfiar 10GB lá.. não havia espaço para mais certamente. Caso fosse o oposto já não era bem assim a conversa.

Passa lá essas ideias, e mete mais umas palas. 😉

Neste momento o melhor combo será full AMD. nvidia ja teve o seu tempo, durou tanto que até tempo tiverem pra roubar os clientes com preços astronómicos.

Vou corrigir o título

A AMD RX 6800 XT é mais rápida do que a Nvidia Rtx 3080 em 1080p e 2K.

Perde em 4K em alguns jogos numa medida de 6fps.

Relembrando que as avaliações são feitas com os primeiros drivers.

O título está bem.

Como é que o titulo está bem, se a 3080 apenas ganha a 4K, a qual é usada apenas por 2.3% dos jogadores?

Já percebemos que não convém…

A AMD tem de se chegar à fr€nt€ para ter artigos publicados eheh.

Deves andar desatento… estiveste de férias?

Eu ajudo: https://pplware.sapo.pt/tag/amd/

E isso não está explicado no post? Ou agora os artigos escrevem-se no título?

Resto de bom domingo.

Revisão independente da 6800 em https://www.youtube.com/watch?v=jLVGL7aAYgY

Por curiosidade fui ver o site guru3d e eles andam a fumar alguma coisa estragada. Mas vejam https://www.guru3d.com/news-story/review-average-of-17-websites-shows-6800-xt-to-be-7-4-slower-than-geforce-rtx-3080.html e no Tom’s Hardware diz claramente “Dropping to 1440p, the RTX 3080 and 6800 XT are effectively tied — again, AMD wins several games, Nvidia wins others, but the average performance is the same”. Estes fulanos que fizeram esta “compilação” de resultados fizeram o curso online do Trump “A arte de enganar”.

O artigo menciona expressamente 4K

Ligas o rt das AMD e já foste ! … E pena ! Mas estão a começar na área

A guerra comercial entre a AMD e NVidia nunca teve tao acesa, com a AMD a lançar novas gráficas e tornando o mercado extremamente competitivas.

O que me leva a perguntar, o que significa em termos reais ter em media 7% de melhor desempenho em 4k?

Se a RX 6800 XT tiver 60 fps em media num determinado jogo 4k a RTX 3080 terá 64,2 fps de media…

Se a RX 6800 XT tiver 40 fps em media num determinado jogo 4k a RTX 3080 terá 42,8 fps de media

Extremamente competitivo, não esquecer que são gpu lançados pela AMD e NVidia(FE), quando forem lançadas as gpu’s pelos parceiros comercias com melhores clock poderá ser possível ver uma RTX 3080 igualar uma RTX 3090 lol…

O mesmo poderá acontecer entre uma RX 6800 XT (Asus, Msi, Gigabyte) bater uma RTX 3080 (FE) por 3 a 5%. As que tiverem um desempenho menor também serão as mais baratas.

https://www.guru3d.com/articles_pages/amd_radeon_rx_6800_review,13.html

No Assassins Creed: Valhalla teve sempre no topo da tabela com exceção do 4k onde ficou 4FPS abaixo da RTX 3090.

Neste caso ficou acima da RTX 3080 expeto em 4k onde teve o mesmo desempenho.