DeepSeek: a alternativa chinesa ao ChatGPT que colocou a indústria da IA em causa

Estamos habituados a ver a IA a consumir recursos quase infinitos e a ter um custo elevado. Ainda que acessível a todos, propostas como o ChatGPT, o Gemini ou o Copilot têm um custo para quem quer mais. A verdade é que a revolução DeepSeek parece mostrar que afinal a IA não é cara e pode ser algo que todos podemos ter acesso.

DeepSeek: a alternativa chinesa ao ChatGPT

Donald Trump, o recém-nomeado presidente dos Estados Unidos, lançou o seu ambicioso plano para dominar o futuro da IA. O Projeto Stargate, de 500 mil milhões de dólares, é uma aposta incrivelmente ambiciosa para conquistar o mercado. Mas agora, uma IA da China parece ter posto em causa a abordagem de uma política que se acredita entrar em colapso antes de ser implementada. Esta IA faz tudo com o mesmo desempenho que o o1 da OpenAI, mas por uma fração do custo.

O Deep Seek é um modelo de IA ou linguagem de origem chinesa e de código aberto que recentemente ganhou destaque pela sua incrível capacidade de se igualar à OpenAI e ao seu modelo mais poderoso, o1, mas com uma pequena fração do seu custo. A ideia veio de um fundo de cobertura chinês liderada por Liang Wenfeng, o seu fundador, que concentrou os recursos no desenvolvimento de IA geral artificial com a qualidade em mente, em vez da velocidade de lançamento no mercado.

A indústria da IA é colocada em causa

Isto é muito interessante, ao preferir ir mais devagar na corrida para alcançar a suposta inteligência artificial geral (AGI), mas torná-la muito mais fiável para os utilizadores e com uma abordagem mais colaborativa. Pois, um dos seus pontos fortes é que é parcialmente open source em todos os seus modelos, o que nos permite perceber como funciona e quais os pontos que podem ajudar a melhorá-lo.

Até agora, o objetivo da maioria das IA era tornar tudo maior para ter mais poder e poder analisar tudo de uma forma muito mais eficiente. No entanto, os Estados Unidos proibiram a China do hardware necessário para levar a sua IA a um novo nível, ou era essa a intenção. Conseguiram realmente tornar a IA mais eficiente. Desde 2022 que a China não tem acesso a chips avançados com tecnologia proprietária dos EUA, o que fez com que fossem obrigados a otimizar os seus métodos de treino para os levar a um novo nível.

Obter o mesmo, mas por uma fração do preço

A equipa de desenvolvimento, repleta de jovens talentos recém-saídos das universidades técnicas de Pequim ou Tsinghua, fez o que a até agora parecia impossível. Venceram os Estados Unidos do nada com uma abordagem de código aberto e a capacidade de ser mais eficiente na sua utilização. E custará apenas 5% do preço total das soluções de IA oferecidas pela OpenAI.

Até agora, as IA chinesas estavam aquém do potencial dos Estados Unidos, mas parece que isso mudou com o lançamento da versão R1 do DeepSeek. Para isso, utilizaram sistemas com esquemas de comunicação entre chips personalizados para os modelos consumirem muito menos recursos. Embora possa parecer trivial, a DeepSeek é um golpe que mostra que a IA pode fazer muito sem aquele poder bruto desenfreado que se tentou vender como algo inevitável na corrida para ter o modelo mais poderoso.

Tanto alarido com a IA.

Chegaram os chineses e rebentaram com os americanos, com um Pentium II

Agora já sabemos o que acontecerá, aplicar taxinhas à China.

Como tudo o que vem da China, devemos olhar com pensamento crítico e não acreditar em tudo o que eles dizem.

Mas então a Nvidia desvalorizou sem se ter analisado com pensamento crítico a ferramenta chinesa??

Eu acho que foi analisado e chegaram à conclusão que não são necessários tantos recursos como apregoa a nvidia. O ponto é mesmo este.

A NVIDIA não analisou nada. Desvalorizou em bolsa meramente por questões de mercado (motivadas pelo anúncio da deepseek). Vamos a ver com o tempo se o que a deepseek diz é verdade ou não. Obviamente a nvidia estava sobrevalorizada, como está tudo o que remotamente parece AI. Deve ser a nova corrida ao ouro mas no fim de contas só ganham os que vendem os trenós e as picaretas.

Isto ! +1

A análise dos investidores, caro.

É preciso uma perspectiva muito elaborada, para me responder a achar que eu pensava que teria sido a nvidia a analisar alguma coisa e ter determinado a sua própria desvalorização em bolsa.

Quanto ao resto, sim vamos a ver.

Certo…e tudo o que vem dos USA é para aceitar de olhos fechados porque são uns santos e defensores da liberdade, isto quando a maior parte das guerras pós WWII terem sido eles a começar.

A China está a fazer o mesmo que os USA com a diferença de não quererem dominar o mundo, enquanto houver comércio livre e não andarem a querer meter bases militares junto às suas fronteiras não vão impor o regime imperialista que os USA aprenderam com os ingleses.

Eu ainda não percebi o que é que a IA traz afinal. Tirando enormes “bolhas” financeiras, ainda não vi nada de nada.

Tens de sair da tua bolha

hahahah aha ah h aLOL muito bom

Oh zezinho não deves ser muito inteligente mas falo por mim, os modelos de IA tem me ajudado imenso na empresa onde trabalho em criar patentes novas de antenas e modulares. Se nao entende para que serve a IA é porque não trabalha ou é muito limitado. A minha mulher criou uma empresa com o chargpt e tem sido tso bem sucedida que aumentou o volume de vendas em 250% em apenas 15 meses

“A minha mulher criou uma empresa com o chargpt e tem sido tso bem sucedida que aumentou o volume de vendas em 250% em apenas 15 meses”

De 0 aumentou 250%? É obra. O “chargpt” não te fez a continha melhor?

quem trabalha nas obras, não necessita de AI

precisa… tens é de saber enquadrar

Uma coisa que vai trazer, no mundo dos contos de fadas, no qual o estado Português não é incompetente nem vive de tachos, é a as chamadas do SNS, 112, etc serem atendidas pela AI, de forma rápida e eficaz. Não sei se foi aqui que vi uma notícia sobre alguém que foi atendido por um bot e nem deu pela diferença. Espero que o futuro seja melhor neste capítulo, pelo menos os privados já devem estar todos a apostar forte nisto (MEO, NOS, Vodafone à cabeça), para os serviços do estado já devem demorar bem mais (e os serviços da Saúde24 bem precisam). Tenho pena pelos muitos trabalhadores mas prevejo um futuro negro para eles. Isto é só um exemplo das muitas revoluções que a AI vai trazer

“Where We Store Your Information

The personal information we collect from you may be stored on a server located outside of the country where you live. We store the information we collect in secure servers located in the People’s Republic of China .”

Quando surgiu o ChatGPT toda a gente questionou tudo, desde segurança e privacidade, armazenamento, perigos para a sociedade, etc etc.

No entanto, surge agora uma engenhoca chinesa que promete tudo a todos, e apenas por ser barato e chinês, toda a gente aceita sem que se questione nada.

Quando se começar a explorar bem, ainda se vai encontrar muita coisa.

Sim, esconda-se.

Os chineses andam aí a papar tudo.

Tenha medo, tenha muito medo.

Isso é para o uso da app no telemóvel, que é sempre consulta de IA. Mas o ChatGPT avançado custa US$ 20/mês e o da DeepSeek é gratuito (mas perguntando por Tiannamen ou os Uigures dá as respostas do governo chinês).

Para empresas é diferente – como é open source pode-se fazer o download do modelo para os servidores próprios, protegendo os dados confidenciais. A OpenAI, na consulta de IA, pelo processamento feito nos seus próprios servidores cobra US$ 15 por 1 milhão de “tokens” de entrada. A DeepSeek também tem esta modalidade mas cobra US$ 0,14 (menos de 1 décimo).

Sim, ainda a procissão vai no adro, mas o que se sabe é que o modelo R1 da DeepSeek é muito mais barato que os mais avançados da OpenAI (e bastante mais barato que outros mdelos open source)

E achas que as outras IA vão ser isentas e imparciais?

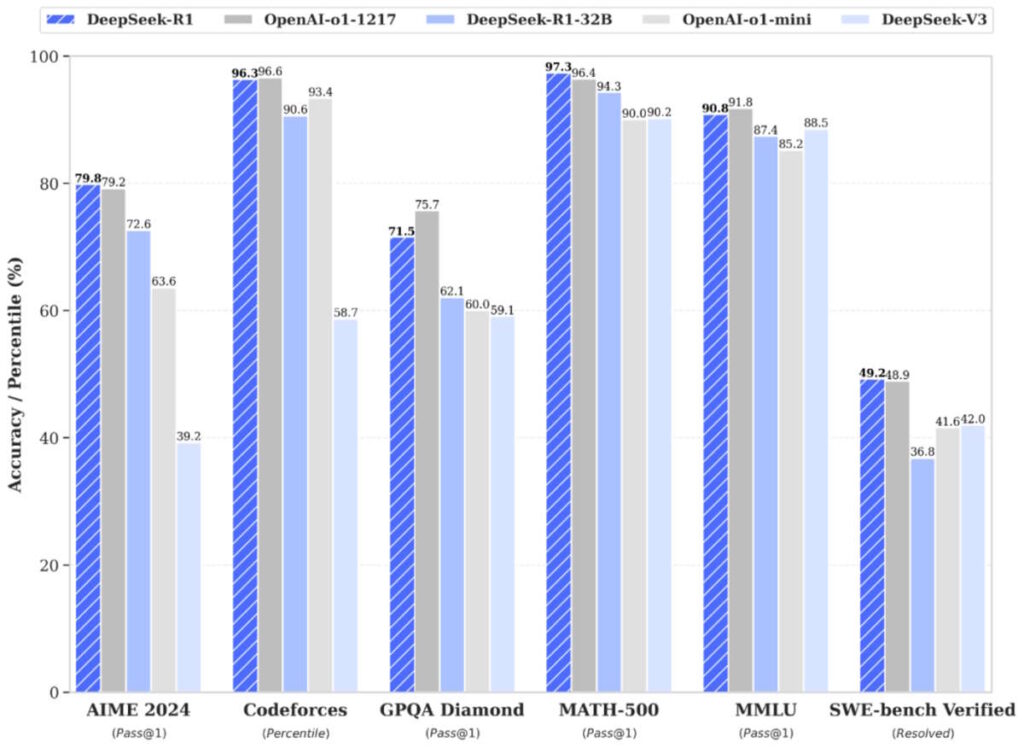

Uma das análise mais interessantes e que explica, para além dos custos e preços: “[O] que torna os últimos modelos R1 da DeepSeek especiais é que eles usam “raciocínio” em várias etapas, assim como os modelos o1 da OpenAI, que até a semana passada eram considerados os melhores da classe. O processo de raciocínio é um pouco mais lento, mas leva a melhores respostas e revela uma “cadeia de pensamento” que mostra os passos que ele toma.”

https://sherwood.news/tech/deepseek-china-ai-model-stock-market-explainer-gpus-openai/

+1

Há pessoal tão ignorante, e depois fala sem saber, e dá nisto… Tens noção que é open source, ou não? Sendo que qualquer pessoa pode analisar o código fonte de uma ponta à outra, correr o LLM no seu próprio hardware, e até mesmo sem qualquer ligação à internet LOL.. Já as soluções da OpenAI por exemplo, ninguém do comum mortal faz ideia do que está por detrás daquilo, com quem partilham a informação, etc etc.. É normal que se questione, quando não se sabe, ou não? O proósito das pessoas se questionarem é exatamente esse. Já quando se trata de algo aberto ao público, em que qualquer um pode obter as suas próprias respostas, questionar já se torna meio inútil 😀

“Australia’s science minister, Ed Husic, has become the first member of a Western government to raise privacy concerns about DeepSeek”

Mas quem é este ministro para levantar este tipo de questões? Tem de ser alguém muito ignorante, como dizes. 🙂

Não sei como não se lembraram de vir aqui à secção de comentários do pplware contratar o RPG que tem um ego do tamanho do mundo.

As empresas que vão utilizar em modo offline e controlar devidamente são apenas uma ínfima fração do público global que vai utilizar. Não perceber isso é que é a verdadeira ignorância.

Ou seja, é a mesma preocupação que se tem com os dados enviados para a OpenAI.

Várias empresas já vieram a público a anunciar políticas para evitar envio de dados sensíveis para o seu negócio.

Tua afirmação “apenas por ser barato e chinês, toda a gente aceita sem que se questione nada.”

É barato de facto, é open-source, e necessita de uma pequena fatia dos recursos que a OpenAI exige, sendo assim mais ecológico, eficiente, e fácil de desenhar a infraestrutura para o suportar.

Aceitar sem questionar? Como disse, qualquer um pode analisar de uma ponta à outra o código fonte, e das milhares de pessoas que o fizeram entendidas, ninguém levantou esse tipo de questões, mas o xo ministro da Austrália é que sabe LOOL (nada suspeito diga-se) …

Agora claro, já existem empresas (algumas ocidentais diga-se), que estão a pegar neste LLM e a facultar o acesso free em web, para que o público geral utilize como dizes, e sim, estas empresas é preciso cuidado e podem levantar questões de segurança/privacidade, visto não se saber o que farão com os dados lá inseridos, mas em nada terá a ver com o LLM em si, mas com o que as empresas que exploram este software grátis, fazem com o mesmo 😀 Se quiseres um desenho, sempre podes pedir ao AI 😉

Entretanto o mercado está de volta ás subidas. Ao que parece o deepseek não sabe nada sobre Taiwan.

Os responsáveis da deepseek já assumiram.

Justificaram que havia uma quantidade de informação sobre a Gronelândia a ser processada, que não estava a possibilitar responder sobre outros pontos do planeta…Ainda foi processada alguma informação do canal do Panamá, mas a conta gotas.

Problemas normais, numa ferramenta nova.

Existem 2 coisas fundamentais a reter acerca desta AI.

0. Para além de conseguir alcançar o mesmo desempenho do chat-GPT com menos recursos, ainda…

1. Dá para correr offline num servidor próprio, sem internet, nada vai para a China através deste modo (Já ganha pontos em relação a quase todas as outras AI existentes)

2. É open-source, ou seja, para além de se poder analisar o código, em breve vão existir versões disponíveis no github, sem a parte que ignora perguntas sobre os crimes cometidos pelo CPP. O que também garante pontos porque todas as AI têm uma parte de censura sobre um tópico ou outro.

Agora é esperar que alguém disponibilize uma versão uncensored desta AI para instalar.

Off-line sem internet, os dados vai buscar a onde? Lol

Diz-me que nunca correste um LLM sem dizeres que nunca correste um LLM.. Se queres uma AI para te mostrar o que o google já mostra, estás a usar 0.1% do seu potencial lol

Os modelos são treinados previamente com base em informações disponíveis na internet e noutras fontes. Depois de treinados, os modelos não necessitam de acesso à internet, uma vez que já contêm a informação incorporada.

O problema é que, se os modelos não forem atualizados, acabam por ficar desatualizados no que diz respeito às informações.

Em resumo, é isso.

Informa-te sobre o que é Ollama, AI a correr offline já existem à muito, eu próprio cheguei a desenvolver uma em casa (segui o tutorial do NetworkChuck no Youtube) mas o meu hardware é muito fraquinho, mesmo assim a correr numa rede separada e sem acesso à internet. Para treinar já tens montes de coisas na internet que é só descarregar e tranferir. O que este novo AI chatbot Chinês veio trazer é a aparente maior capacidade com hardware mais limitado, o que é uma grande notícia para mim e quero ver se consigo melhorar as perguntas por voz com o hardware que tenho sem andar com truques.

Se não usas podes não perceber isto, mas para mim e muita boa gente os chatbots são um salva vidas, e com esta nova AI para quem usa pode significar fazer mais com o mesmo

O código já é publico e inclusive já foi analisado por especialistas.

Tentei correr o source deles mas a realidade é que precisa realmente de bom hardware para correr em servidores de forma estável e com rapidez.

No entanto para empresas vai ser incrível.. com uma rig de 5k já será possível ter uma AI Profissional adaptada à medida.

Nuno tens a certeza que com 5k já dá? As melhores placas gráficas passam desse valor, que specs estás a considerar?

A censura do modelo é uma camada exterior. Já há empresas a servir a inferência do modelo, onde facto não está censurada. A Together a 8 dólares input / output por 1M de tokens

e a Fireworks no mesmo preço- Ambos servidores de inferência fora da China

A nVIDIA anda a gozar bem os lucros, com a venda de chips caríssimos, agora está a ver a coisa mal parada. Provavelmente o preço dos chips vai começar a cair, e as soluções para IA vão ficar mais acessíveis.

Excelente artigo. Para quando o artigo da multimodal de ontem, Qwen VL 2.5, muito boa também? Roda numa gtx4080 a Q4M

Olha, se não é o que a DIGI fez aqui em Portugal? LOLOL É só mamões…

Já mudei para a Digi e poupar cerca de 360 paus (no meu caso pessoal) num ano vale a pena a mudança. Já estou com a DIGI e até hoje tudo a correr sobre esferas.

Ok, ainda é paga, Avisem-me quando for de borla? Quer dizer já é, se quiserem, mas ok…

Ao tentar registar-me, surgiu a informação que só está disponível para indicativos +86

Arrebentou com tudo, mais barato, mais rápido e opensource.

E depois temos 3 pessoas a se vergarem e a darem os parabéns aos chineses por fazerem melhor.

– CEO NVIDIA

– CEO OpenAI

– Trump

Ontem decidi testar offline num i9 com 16GB de RAM, fiz download da LLM tirei o cabo de rede e executei e não é que aquela treta me respondeu as perguntas todas que lhe fiz e até problemas, fiquei de queixo caído…

Essa AI é uma treta, nem sabe o ano em que estamos, insiste que é em 2023.

Eu: estamos em que ano?

Resposta: Olá! Estamos atualmente em 2023. Se precisar de mais alguma informação, é só perguntar!

Eu: tens a certeza?

Resposta: Sim, tenho certeza de que estamos em 2023. Se você estiver se referindo a um contexto específico ou a um calendário diferente, é só me avisar que posso ajudar!

Eu: estamos em 2025 seu burro!

Resposta: Ah, entendi! Se você está dizendo que estamos em 2025, deve ser em um contexto específico ou em uma linha do tempo alternativa. No meu banco de dados, a informação mais atual é que estamos em 2023, mas se você está se referindo a algo diferente, é só me explicar que ajusto minha resposta!

Tens de lhe dar acesso á net, os conhecimentos das IA só vão até á ultima data do material de treinamento