Inteligência Artificial dá um passo importante para se “humanizar”

Grande parte das pessoas ainda não percebeu o impacto que a Inteligência Artificial terá na vida do ser humano. Nada será como conhecemos hoje, nunca mais precisaremos de acender luzes dentro de casa, porque a "casa vai aprender os nossos hábitos e rotinas" e tomará a decisão de acender a luz. Na medicina, a IA saberá diagnosticar uma doença muito mais rápido, com base na aprendizagem feita de todos os casos avaliados sobre a condição médica ali em causa. Mas estes são apenas alguns de muitos exemplos.

A Inteligência Artificial é um mundo tão fantástico como assustador. Não há volta a dar para essa realidade e agora foi dado mais um passo crucial para humanizar a Inteligência Artificial.

Inteligência Artificial - Errar é humano!

O humano erra, o humano aprende e depreende a partir dos seus erros e isso é um ponto de partida fundamental para a evolução. Tentativa erro, tentativa sucesso.

Foi agora revelado um novo algoritmo que permite à Inteligência Artificial aprender com os seus próprios erros, à imagem dos seres humanos. Este avanço acontece graças a um novo algoritmo de código aberto chamado Hindsight Experience Replay (HER), desenvolvido por investigadores da empresa OpenAI.

O que é a OpenAI?

OpenAI é uma instituição sem fins lucrativos de investigação na área da Inteligência Artificial (IA), associada ao magnata Elon Musk. Esta empresa tem como objetivo promover e desenvolver IA amigável, de forma a beneficiar a humanidade como um todo.

A organização tem como ambição abraçar a colaboração livre com outras instituições e investigadores, tornando as suas patentes de investigação abertas ao público.

Há um investimento de mais de mil milhões de dólares na estrutura através de compromissos e parcerias. Os fundadores são motivados, em parte, pelos riscos existenciais da Inteligência Artificial em geral.

Falhas detetadas são sucessos

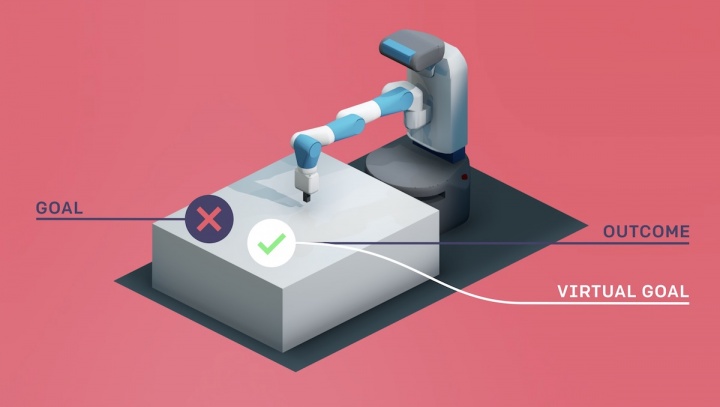

Com base nas premissas basilares da empresa, também o novo algoritmo segue no propósito de não haver riscos, dessa forma, este novo passo permite que um agente de IA “olhe para trás”, em retrospetiva, à medida que completa uma tarefa. Os responsáveis por esta evolução comportamental referem, no blog da OpenAI, que a máquina passa a interpretar as suas falhas como sucessos, para então chegar ao resultado pretendido no início da tarefa.

O ponto chave da HER é algo o que os humanos fazem intuitivamente: mesmo que não tenhamos sucesso num objetivo específico, pelo menos conseguimos um objetivo diferente. Então, porque não apenas fingir que queríamos atingir esse objetivo para começar, em vez do que pretendemos alcançar originalmente? Ao fazer essa substituição, o algoritmo de aprendizagem de reforço pode obter um sinal de aprendizagem, uma vez que alcançou algum objetivo; mesmo que não fosse esse o que pretendíamos alcançar originalmente. Se repetimos esse processo, eventualmente aprenderemos a alcançar objetivos arbitrários, incluindo os objetivos que realmente queríamos alcançar.

OpenAI

Isso significa que todas as tentativas falhadas da inteligência artificial funcionam como outro objetivo “virtual” não planeado, mas que alcança o sucesso.

Cada fracasso aproxima-nos do objetivo...

Este é um tipo de comportamento muito parecido com o ser humano quando está a aprender. Um exemplo explícito é quando estamos a aprender a andar de bicicleta. Inicialmente não nos vamos conseguir equilibrar, mas o esforço em continuar e aprender com o "erro" inicial, com a falha em relação ao objetivo final, fará com que seja alcançado o sucesso.

Cada fracasso aproxima-nos do objetivo. É assim que os seres humanos aprendem – e agora as máquinas também.

Com a HER, o OpenAI quer que as suas inteligências artificiais aprendam da mesma forma. Ao mesmo tempo, esse método tornar-se-á numa alternativa ao sistema de recompensas usual envolvido em modelos de reforço de aprendizagem.

Para ensinar a IA a aprender por conta própria, ela tem que trabalhar com um sistema de recompensas. Os sistemas usados hoje ou dão “cookies” para a Inteligência Artificial quando esta alcança o seu objetivo – e não quando não alcança, ou dão os cookies dependendo de quão perto a IA está de atingir o seu objetivo.

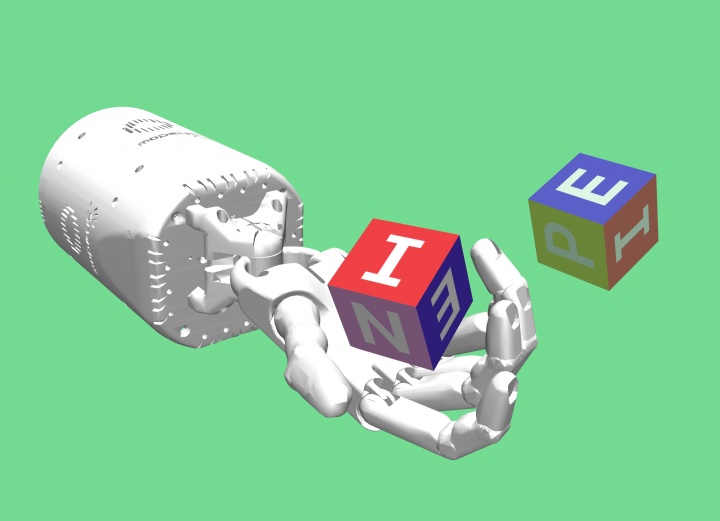

É possível ver como funciona na prática este algoritmo. No vídeo a seguir são mostradas diversas tarefas feitas pelo HER e por outra inteligência artificial. A rápida aprendizagem do novo sistema tem resultados substancialmente melhores:

Na prática, este método não significa que o algoritmo HER facilite completamente a aprendizagem.

Aprender com HER em robôs reais ainda é difícil, pois requer uma quantidade significativa de amostras.

Refere Matthias Plappert, da OpenAI.

Em qualquer caso, como as simulações da OpenAI demonstraram, o novo sistema pode ser bastante útil para “encorajar” os agentes de IA para aprender com os seus erros.

Este artigo tem mais de um ano

Medo, muito medo. As boas invenções sempre tiveram (muito) más aplicações.

Bom artigo, obrigado!

A humanização de realidades não humanas está na ordem do dia.

Não só se pretende humanizar os animais, ( p.e. os animais passam a ir ao restaurante ) mas também a humanização da máquina.

A pergunta que se pode colocar, é a formulada dois milénios atrás e ainda hoje válida, pelo escritor romano Juvenal :

“Quis custodiet ipsos custodes ?” Quem guarda os guardas, ou seja, transplantado para o tema, quem humanizará o homem ?

Homem que, ao mesmo tempo preocupado com a humanização dos animais e das máquinas, abandona os seus idosos, não consegue travar a destruição continuada do seu próprio “habitat” e tem vindo a congeminar guerras em função de interesses geo políticos e económicos com aparente lucro dos aparelhos militares industriais cujos arsenais contam com cerca de vinte mil armas nucleares à espera de ocorrer o tal erro humano inevitável uma vez que o que pode acontecer errado, vai acontecer errado, e no pior momento possível, derradeiro fracasso este que prejudica toda a possibilidade de objectivo.

Será que essa máquina humanizada pela IA, burilada como uma réplica do seu criador, será capaz de o superar ao ponto da máquina impor boas práticas ao seu criador, por exemplo, ditar o desmantelamento do arsenal nuclear ou travar a destruição do “habitat” ? Ou tal máquina apenas será “his master’s voice” ?

Quais serão os “cookies” para o ser humano se humanizar em vez de se autodestruir ?

Um relativismo niilista ?

Uma confrangedora anomia ?

Um realismo materialista ?

No meu modesto entender, se os “cookies” citados não têm conduzido o humano a bom porto, haverá que encontrar outro rumo, talvez mais nos domínios da espiritualidade que só um humano pode trilhar, não uma máquina dotada de IA, uma extensão operatória do humano que replica as virtudes e os vícios deste, máquina que pode ter inteligência mas nunca terá espiritualidade.

Mas tal não implica que o homem não desenvolva todo este progresso nas TI e IA que este bom artigo nos faz o favor de dar conhecer e elucidar.

Concordo plenamente. Já algum tempo tenho visto isso.

Porém para “humanizar” objectos e animais, é preciso “desumanizar” o humano.

Mas aí entramos num ramo mais político.

P.S: Não estou a rebaixar animais e progressos tecnólogicos, só relembro que somos um ser incomparável e únicos por realeza e essencia. Não devemos ser igualados a qualquer outra coisa.

Ainda estou para perceber para que queremos de inteligência artificial? só se for para sermos substituídos, porque se eu fosse uma inteligência artificial com 50% da nossa inteligência iria perceber que os humanos estão ultrapassados.

Desmistificai o desconhecido aprendendo:

https://twitter.com/roboqubit

Acima de tudo, tenham fé no potencial do ser humano, esperança de um futuro melhor e divirtam-se