Marcas no asfalto podem ser suficientes para “hackear” o piloto automático de um Tesla

A Tesla marcou uma viragem no mundo automóvel. Contudo, criou igualmente um desafio para ataques à segurança eletrónica dos veículos. Nesse sentido, a empresa de segurança Tencent Security Lab Keen divulgou na sexta-feira passada um relatório interessante. Foram detalhados vários ataques contra os veículos Tesla. Como se pode ler, há fragilidades encontradas no software do Piloto Automático Tesla.

Será que os ataques aos Tesla poderão comprometer o avanço dos veículos autónomos?

Ataques ao sistema Tesla são um "novo desafio"?

Conduzir um carro da Tesla para fora da estrada numa condução normal, potenciando uma colisão, é possível. Não, nem é necessário "entrar e hackear" o avançado sistema de assistência ao condutor do veículo (Piloto Automático Aprimorado).

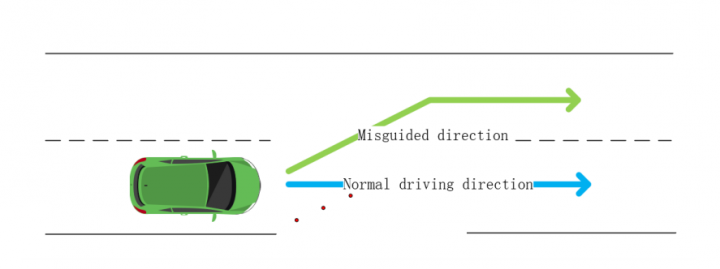

Ou seja, ao pintar manchas de interferência na estrada, os investigadores demonstraram que um Tesla Model S 75 pode seguir um caminho falso. Assim, sem pedir permissão ao condutor, o componente Autopilot muda autonomamente de faixa de rodagem.

Na base desta tecnologia está uma sofisticada rede de computadores que interpretam os dados ambientais em tempo real. Desta forma, a máquina age de acordo com os padrões autorizados. Esta rede computacional usa a informação recolhida principalmente através de câmaras, sensores ultrassónicos e radar.

Descobertas formas de ataque aos Tesla

Marcas desenhadas no asfalto podem permitir ataque de "pista falsa". Conforme foi identificado pelos investigadores, a tecnologia de deteção da pista funciona quando o modo piloto automático está ativo. Estes testes foram realizados com a versão de hardware 2.5 do Autopilot e a revisão de firmware 2018.6.1.

Responsável por este procedimento é a função "detect_and_track", que também alimenta dados para kernels CUDA. Estes dados são usados para determinar e interpretar corretamente a marcação na estrada.

A imagem acima descreve o processo usado pela Tesla para determinar a presença de uma faixa no quadro atual. Por outro lado, este é o mesmo processo que o veículo usa para avisar da saída de pista, conforme explicam os especialistas chineses num trabalho de investigação divulgado recentemente.

Com base nestas informações, o carro constrói um mapa virtual, que contribui para a criação de um mapa HD em tempo real para outros componentes (mecanismo de perceção, controladores). Portanto, se o sistema for induzido a detetar uma linha falsa, o carro seguirá essa informação acreditando que está a seguir a pista legítima.

Os especialistas do Keen Security Lab puderam enganar com sucesso o módulo de visão do piloto automático do Tesla e executar um ataque de "pista falsa" pintando no chão de teste três pequenos quadrados.

O módulo de visão do carro interpreta-os como uma pista de confiança levando o autopilot a acreditar e seguir as indicações. Assim, durante o teste, o veículo viu os desenhos como uma supressão da faixa da direita e seguiu essa linha. Tal comportamento levou a que o Tesla mudasse de faixa sem que fosse suposto fazê-lo, algo que pode comprometer a segurança rodoviária.

Ataques antagónicos aos veículos Tesla

Na verdade, poderemos estar perante um novo tipo de ataques. O alvo é claramente o sistema "inteligente" responsável pela interpretação dos dados recolhidos pelos sensores.

Conforme referem os investigadores, este tipo de ataque é simples de implantar e os materiais são fáceis de obter. Desta forma, os resultados obtidos pelos testes provam que a decisão de condução dos carros da Tesla dependem exclusivamente da solução de visão computacional para detetar pistas.

As nossas experiências provaram que esta arquitetura tem riscos de segurança e o reconhecimento de faixas invertidas é uma das funções necessárias para a condução autónoma em estradas não fechadas.

Escreve a empresa Keen Security Lab.

Deve-se notar que os testes ocorreram num ambiente controlado e que os carros Tesla têm uma gama de parâmetros projetados para impedir a deteção incorreta de detalhes reais: verificar a distância entre objetos, a posição das bermas da estrada, histórico da pista, mapas internos, etc.

Controlo remoto de um Tesla com um comando de jogos

A investigação da empresa mergulhou mais fundo na rede do veículo, tentando obter o controlo remoto do sistema de direção.

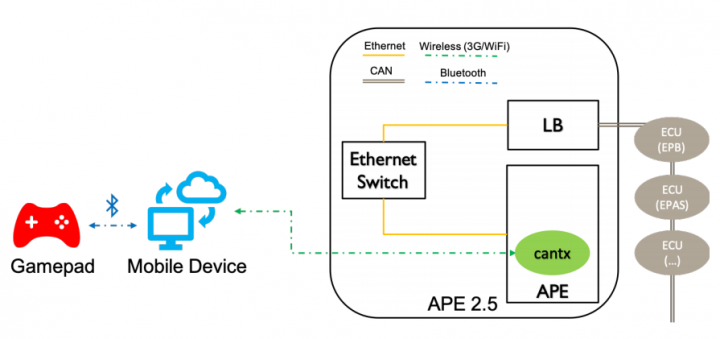

Para isso confiaram no privilégio de acesso à raiz do Autopilot ECU (APE), adquirido pela exploração de vulnerabilidades em diferentes componentes e demonstrado em trabalhos anteriores da equipa. No entanto, as falhas detetadas na versão 2018.6.1 do firmware do carro foram corrigidas numa versão subsequente do software (2018.24).

A partir do acesso root ao APE, a equipa foi capaz de influenciar a unidade de direção assistida elétrica (EPAS) do veículo através de mensagens CAN arbitrárias e controlá-lo em vários modos de condução. Desta forma, as instruções de direção foram enviadas de um dispositivo móvel, que pode traduzir os sinais de controlo nos comandos correspondentes do sistema de direção.

Para um controlo mais confortável do carro, os instigadores usaram um comando de jogo ligado ao telefone via Bluetooth.

Descobertas várias informação sobre a forma como os Tesla atuam

A equipa referiu que durante os testes, descobriu diferentes tipos de resultados mediante diferentes abordagens:

- Quando o carro está estacionado, puderam assumir o controlo do sistema de direção sem limitações;

- Quando o carro foi trocado do modo R (Reverse) para o modo D (Drive), o APE parece achar que o carro está no modo APC (Automatic Parking Control). Isto permitiu controlar o sistema de direção numa velocidade de cerca de 8 km/h.

- Com o carro está no modo ACC (Adaptive Cruise Control) em alta velocidade, o sistema de direção também pode ser controlado sem limitações.

- Mesmo quando o carro não está no modo ACC (Adaptive Cruise Control), o volante também pode ser comprometido numa tentativa.

A partir das escovas do para-brisas

Além de controlar a direção do carro, os especialistas também mexeram nos para-brisas. Ao contrário dos carros comuns, que usam sensores de humidade para detetar as gotas da chuva, a abordagem da Tesla usa várias câmaras do piloto automático e inteligência artificial para determinar quando iniciar as escovas.

Mais especificamente, a câmara fisheye de 120 graus capta as imagens do para-brisa e alimenta-as numa rede neuronal separada para essa tarefa após o pré-processamento. A rede neuronal fornecerá um valor flutuante entre 0 e 1 como a possibilidade de humidade no para-brisas.

Explicaram os investigadores.

Para imitar a chuva, os especialistas simplesmente expuseram as câmaras do carro a uma imagem que ativou o efeito desejado. Se por um lado é uma opção difícil de explorar no mundo real, por outro não é impossível e pode haver quem se aproveite. Desta forma, sinais de trânsito, anúncios exibidos na janela traseira de outro carro, ou outros lugares na linha de visão da câmara podem fazer disparar a ação de limpar os vidros.

Este artigo tem mais de um ano

Imagem: Pplware

Fonte: Pplware/Keenlab

Qualquer dia estão a hakear o carro para se transformar num Decepticon…

duvida, estes carros autónomos, também conduzem em estradas sem marcação???

Por enquanto precisam de ter linhas guia para o fazer.

Isso é mais um dos alertas que a automação representa de risco para a sociedade mas, ainda tem imbecis que confia no maldito robô.

ainda há pessoas que confiam em condutores bêbados por isso não te admires que haja pessoas a confiar em computadores :d

Boa sorte T-1000!

Tinha isto como um bom site para ler noticias mas esta é so ridícula desculpem la isto é uma noticia mesmo ? o carro basicamente segue as marcas da estrada obviamente se numa pista tentarem aldrabar as linhas o carro nao faz o previsto a imagem mostra tudo fizeram uma linha a ir para outra faixa e mesmo assim a faixa que ele ia nao podia ter linhas num certo intervalo se nao o carro detetava-as agr vao la desenhar e apagar linha para a auto estrada para ver o que vos acontece, dps outra estupidez foi a dos para brisas sim o model s e ox usam as camaras para detetar a chuva entao meteram o carro a frente de um projetor e projetaram uma imagem que pode dar a sensação de chuva as camaras espetacular algo mesmo inacreditável gostava de ver no mundo real esta falha gravíssima a ser explorada que nem é bem uma falha é so estupidez humana a tentar fazer algo que nem faz sentido

O que não faz sentido são 7 linhas com apenas uma virgula e sem pontuação. Resultado? Quase não se consegue compreender a tua resposta.

Bom comentário, péssimo artigo

Boa sorte T-1000!