Microsoft revela o Phi-2, uma IA capaz de superar o Llama 2 e o Gemini!

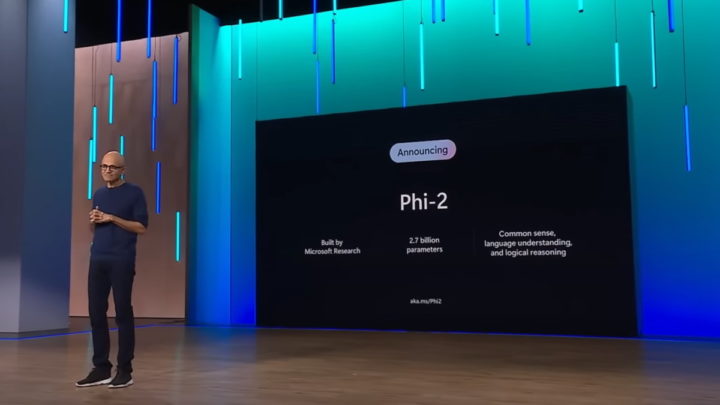

A Microsoft anunciou o lançamento do Phi-2, um small language model (SLM) capaz de superar o Llama 2 da Meta, o Gemini da Google, e outros concorrentes. Desenvolvido pela Microsoft Research, o modelo demonstrou excelentes capacidades de raciocínio e de compreensão da linguagem.

Microsoft acredita que os SLM podem aproximar-se dos LLM

Os investigadores efetuaram vários testes e descobriram que tem um desempenho melhor do que a IA da Meta e a IA da Google em algumas tarefas.

O Phi-2 faz parte de uma família de modelos baseados em transformers que têm um número mais reduzido de parâmetros. De acordo com a Microsoft, a ideia por detrás do seu desenvolvimento baseia-se na premissa de que é possível obter um desempenho próximo de modelos mais extensos, como o Llama ou o Mistral.

Para ter uma ideia da escala, o Phi-2 tem 2,7 mil milhões de parâmetros, enquanto o GPT-4 teria cerca de 1,7 triliões.

Apesar desta limitação, a IA da Microsoft iguala ou supera modelos até 25 vezes maiores. Numa série de testes de matemática e programação, o Phi-2 teve um desempenho melhor do que o Llama 2 da Meta. Os criadores foram mais longe e colocaram-no contra o Gemini Nano 2, onde conseguiu resolver problemas de física de forma semelhante à IA da Google.

Com apenas 2,7 mil milhões de parâmetros, o Phi-2 supera os modelos Mistral e Llama-2 nos parâmetros 7B e 13B em vários benchmarks. Em particular, obtém um melhor desempenho em comparação com o modelo Llama-2-70B, 25 vezes maior, em tarefas de raciocínio de várias etapas, ou seja, codificação e matemática.

Mencionaram os programadores.

Como é que foi possível obter estes resultados com menos parâmetros?

O segredo está no treino... O Phi-2 foi treinado com um conjunto de dados que inclui textos sintéticos de PNL, subconjuntos de código obtidos do Stack Overflow, competições de programação e muito mais.

A Microsoft mencionou que a qualidade dos dados de treino desempenha um papel fundamental no desempenho do modelo. Ao contrário do GPT-4, a Microsoft efetua uma curadoria de dados da Web que são filtrados de acordo com o seu valor educativo.

A nossa combinação de dados de treino contém conjuntos de dados sintéticos criados especificamente para ensinar ao modelo o raciocínio de senso comum e o conhecimento geral, incluindo ciência, atividades diárias, teoria da mente e muito mais.

O treino do Phi-2 demorou 14 dias e utilizou 96 placas gráficas NVIDIA A100. Apesar de não ter sido efetuado qualquer refinamento adicional, o SLM oferece menos toxicidade e enviesamento nas suas respostas em comparação com o Llama 2. A Microsoft Research afirmou ter efetuado testes exaustivos com referências académicas.

Infelizmente, o Phi-2 só estará disponível para projetos de investigação. O SLM será oferecido como parte do Azure AI Studio para incentivar o desenvolvimento de modelos de linguagem. A licença atual não permite a sua utilização em aplicações comerciais, como o ChatGPT...

Leia também...

Este artigo tem mais de um ano

O problema é que estes novos modelos e os novos 7b (que até adoro alguns em Opensource ), são excelentes nos benchs mas depois são burros que nem uma porta em logica e em ridles ou em composição