Afinal, o custo energético do ChatGPT não é tão grande como se pensava

Em outubro de 2023, um estudo realizado por Alex de Vries indicou que uma consulta no ChatGPT tinha um consumo energético estimado de 3 Wh. Essa estimativa derivou de declarações da Google, cujos responsáveis mencionaram que o consumo do ChatGPT era "provavelmente" 10 vezes maior do que o de uma simples pesquisa. Contudo, não é bem assim...

ChatGPT consome 10 vezes menos do que se pensava

No seu estudo, De Vries considerou consultas médias de cerca de 4000 tokens de input e 2000 de output, correspondendo a perguntas e respostas bastante extensas, embora consultas mais curtas sejam mais comuns.

Desde então, muitas mudanças ocorreram tanto para a Google - cujo sistema e infraestrutura são significativamente diferentes de há 15 anos atrás - quanto para o ChatGPT, que também melhorou em termos de eficiência. É muito provável que as consultas da Google sejam agora mais eficientes, assim como as do ChatGPT e de outros chatbots.

A Epoch AI, uma organização sem fins lucrativos conhecida pela criação do benchmark FrontierMath, publicou um estudo onde estima o consumo energético de uma consulta no ChatGPT.

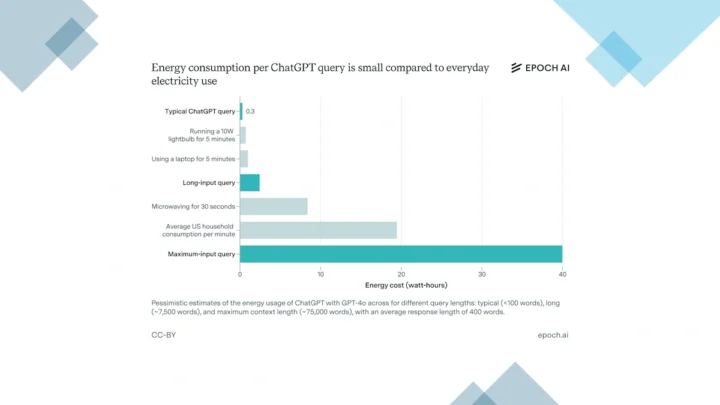

Segundo as suas conclusões, consultas no ChatGPT com o GPT-4o consomem aproximadamente 0,3 watts-hora, o que representa uma redução de dez vezes em relação às estimativas anteriores. O cálculo de 0,3 Wh "é na verdade relativamente pessimista, sendo possível que muitas ou a maioria das consultas sejam ainda mais económicas".

A Epoch baseou os seus cálculos em dados conhecidos, como a informação de que um token da OpenAI equivale a aproximadamente 0,75 palavras e que a geração de um token custa cerca de 2 FLOPs.

Considerando a capacidade de computação das GPUs NVIDIA H100 (989 TFLOPS em operações TF32 e 67 TFLOPS em operações FP32) e o seu consumo energético (1500 W, embora com um consumo real médio de 70% dessa potência), chegaram ao resultado mencionado.

A Epoch AI destaca que a diferença entre esta nova estimativa e a anterior reflete os avanços nos modelos e hardware utilizados pelo ChatGPT desde o início de 2023. Há espaço para melhorias adicionais. Além disso, a estimativa anterior "exagerava na contagem dos tokens necessários".

Este consumo de 0,3 Wh equivale a menos eletricidade do que a consumida por uma lâmpada LED ou um PC em poucos minutos.

Modelos de raciocínio requerem mais energia

Embora tenham usado o GPT-4o como referência, os investigadores observam que o uso de modelos de raciocínio como o1 ou o3-mini aumenta significativamente o consumo energético, embora esses modelos sejam menos populares no momento.

Além disso, destacaram o alto consumo energético associado ao treino de modelos como o GPT-4o, estimando entre 20 e 25 MW durante um período de três meses.

Embora os dados deste estudo indiquem que o uso do ChatGPT não consome tanta energia quanto se pensava anteriormente, os custos energéticos gerais da IA continuam a ser substanciais e devem aumentar significativamente a curto prazo, dado o investimento maciço das Big Tech na construção de centros de dados.

Esses centros terão necessidades energéticas extremamente altas, sem contar com o consumo adicional de ar condicionado.

Leia também:

Este artigo tem mais de um ano

Lá vem novamente o vilão habitual se chegar a frente. Bitcoin

O chat GPT-4o já sofreu 3 alterações desde o verão passado, isso vê-se na API deles, que existem 3 versões diferentes. Sendo que é o mais usado, li no outro dia alguém mais expert do que eu que dizia que a ultima versão e a anterior do GPT-4o tinha perdido alguns pontos em benchmarks de renome, devido mesmo ao facto de muito provavelmente estar mais ” pequeno ” e destilado de forma a ser mais eficiente em todos os aspectos relacionados com a inferência, demanda e custos

Podem dizer o que quiserem.

Epoch Ai não é de confiança:

https://successquarterly.com/epoch-ais-hidden-openai-funding-sparks-transparency-concerns/

Para uma perspectiva, clara, sobre o imensa pegada ecológica de uma reles pesquisa utilizando uma suposta “inteligência artificial”:

https://www.nationalgeographic.pt/meio-ambiente/sede-chatgpt-quantidade-agua-consumida-pela-ia-e-alarmante_5618

So ha mentiras en torno da IA, mentiras atras de mentiras a enganar tolos atrasados.