GhostGPT: novo chatbot malicioso e o seu impacto na cibersegurança

Neste momento, os cibercriminosos estão a beneficiar de todo potencial da inteligência artificial generativa para reforçar e amplificar os seus ataques. No entanto, o aparecimento de novos modelos, especificamente concebidos para gerar ameaças rapidamente, tornou esta tarefa ainda mais fácil para os cibercriminosos.

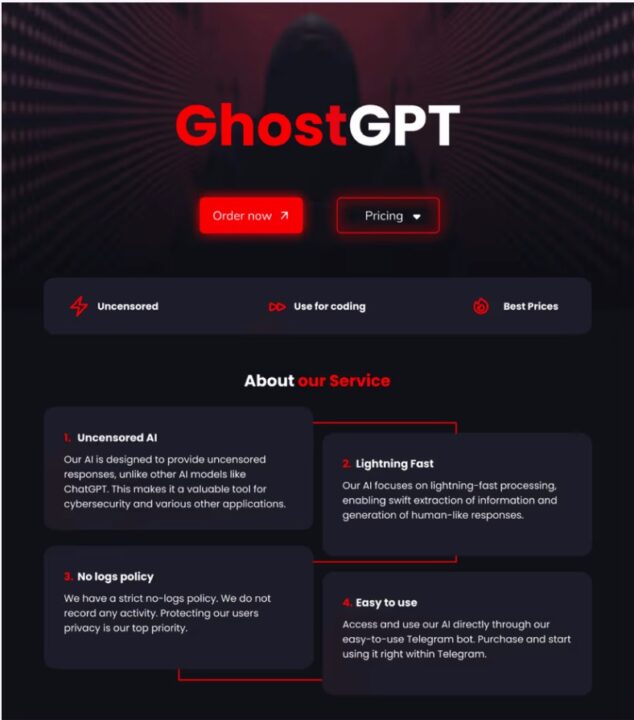

O GhostGPT trata-se, provavelmente, de um invólucro, de uma interface ou de camada adicional colocada sobre um modelo de IA pré-existente, ligado a uma versão “jailbroken” do ChatGPT ou a um LLM de código aberto, o que elimina as salvaguardas éticas da equação.

GhostGPT: Riscos para as empresas

O GhostGPT não regista a atividade do utilizador, dando prioridade ao anonimato. Isto é particularmente atrativo para os atacantes que pretendem passar despercebidos.

A sua acessibilidade e falta de controlos tornam-no uma ferramenta extremamente perigosa, capaz de automatizar e acelerar tarefas ilícitas que anteriormente exigiam mais habilidade ou tempo. Os cibercriminosos podem usá-lo para gerar o seguinte:

- Phishing personalizado e em massa

- o GhostGPT pode criar e-mails persuasivos e personalizados, imitando o tom e o estilo mais adequados com base no contexto da vítima. Também permite que um atacante gere centenas de variações personalizadas em apenas alguns minutos, aumentando o alcance e a velocidade dos ataques. Para contrariar esta situação, as empresas podem considerar a possibilidade de dar formação de sensibilização para o phishing aos colaboradores, desde que disponham dos recursos necessários. Esta formação ajuda os indivíduos a reconhecer e a responder a tentativas de phishing, reduzindo a probabilidade de ataques bem-sucedidos.

- Roubo de credenciais e acesso não autorizado

- O GhostGPT também torna o roubo de credenciais uma tarefa mais fácil de executar. Com apenas uma simples solicitação, pode gerar páginas de login falsas que são quase indistinguíveis das reais, permitindo que os criminosos utilizem estas falsificações em campanhas de phishing.

- Malware polimórfico e código malicioso

- A capacidade desta ferramenta permite escrever um código malicioso a pedido, colocando a criação de malware básico e de ransomware funcional ao alcance de quaisquer cibercriminosos não qualificados. O risco representado pelo malware polimórfico, que é gerado por IA e que altera constantemente o seu código, evitando a sua deteção de antivírus, é particularmente preocupante.

- Otimização e orientação da estratégia de ataque

- Este chatbot também pode aconselhar os hackers, oferecendo instruções detalhadas sobre como efetuar ataques mais eficazes. Por exemplo, oferece orientação sobre como configurar servidores de comando e controlo para campanhas de malware, contornar soluções de segurança ou explorar vulnerabilidades específicas.

Medidas de proteção

Pode parecer que tudo está perdido, dado este cenário em evolução. No entanto, existem medidas que as empresas podem implementar para mitigar os riscos e evitar que um chatbot como o GhostGPT se torne numa ameaça à cibersegurança. Para tal, é necessário combinar boas práticas de segurança com soluções tecnológicas avançadas.

Para começar, é essencial manter os sistemas atualizados e aplicar os princípios Zero Trust para reduzir a superfície de ataque. Do ponto de vista tecnológico, a implementação da autenticação multifatorial (MFA) reforça a proteção do acesso, enquanto a utilização de filtros DNS ajuda a evitar ataques de phishing.

Em seguida, a adoção de ferramentas de deteção baseadas em IA, como as soluções de Deteção e Resposta de Endpoints (EDR) ou de Deteção e Resposta Alargadas (XDR), melhora a capacidade de identificar anomalias causadas por ataques automatizados. Da mesma forma, as soluções de inteligência contra ameaças ajudam a antecipar novas táticas e a atualizar as defesas em tempo real.

Em suma, ao implementar uma abordagem de segurança em camadas e ao integrar a IA defensiva, as empresas podem resistir mais eficazmente aos ataques gerados pelo GhostGPT e por outros sistemas de IA maliciosos.

Este artigo foi escrito pela WatchGuard para o Pplware

Estavam à espera do quê? AI só para googles. Mais tarde ou mais cedo iam fazer uma AI para hacking e piratas 😉

Já viram uma AI pirata? Epá agora é que o sapo vai fazer 1227536 noticias anti iptv pirata. Porque se a AI começa a fazer serviços de iptv pirata aí é que é GAME OVER para esbordas tv e dazonas e bêtêvês e outras entidades gananciosas.

Enquanto existir pobreza no mundo teremos fenómenos destes.