OpenAI lança correção para falha de segurança do ChatGPT mas não resolveu tudo

O ChatGPT foi uma das novidades do ano, em especial pelo que consegue trazer para os utilizadores, para lhes facilitar a vida e o dia a dia. Ainda que seja apenas uma interface de interação, tem por trás sistemas complexos, vulneráveis a ataques. Um novo foi agora resolvido, mas aparentemente a OpenAI deixou ainda portas abertas e dados podem ser roubados do ChatGPT.

Simples roubar dados no ChatGPT

Uma falha de segurança afetava os utilizadores do ChatGPT, que sem saberem tinham as suas conversas roubadas deste serviço. Esta permitia algo que a OpenAI tenta limitar e impedir desde o primeiro dia, procurando manter privadas todas as interações dos utilizadores com este serviço.

Ainda que esta correção consiga já resolver uma parte significativa do problema, a verdade é que é ainda limitada. Segundo o investigador que a revelou, é ainda possível roubar as conversas dos utilizadores e assim obter todo o tipo de informação que ali está presente.

O investigador de segurança Johann Rehberger descobriu uma técnica para obter dados do ChatGPT e relatou-a à OpenAI em abril de 2023. O investigador posteriormente partilhou em novembro de 2023 informações adicionais sobre a criação de GPTs maliciosos que aproveitam a falha para fazer phishing de utilizadores.

OpenAI tentou resolver este problema

Após a falta de resposta da OpenAI, o investigador decidiu divulgar publicamente as suas descobertas a 12 de dezembro de 2023. Ali demonstrou um GPT personalizado, chamado "The Thief!", que pode roubar dados de conversas para um externo URL operado pelo pesquisador.

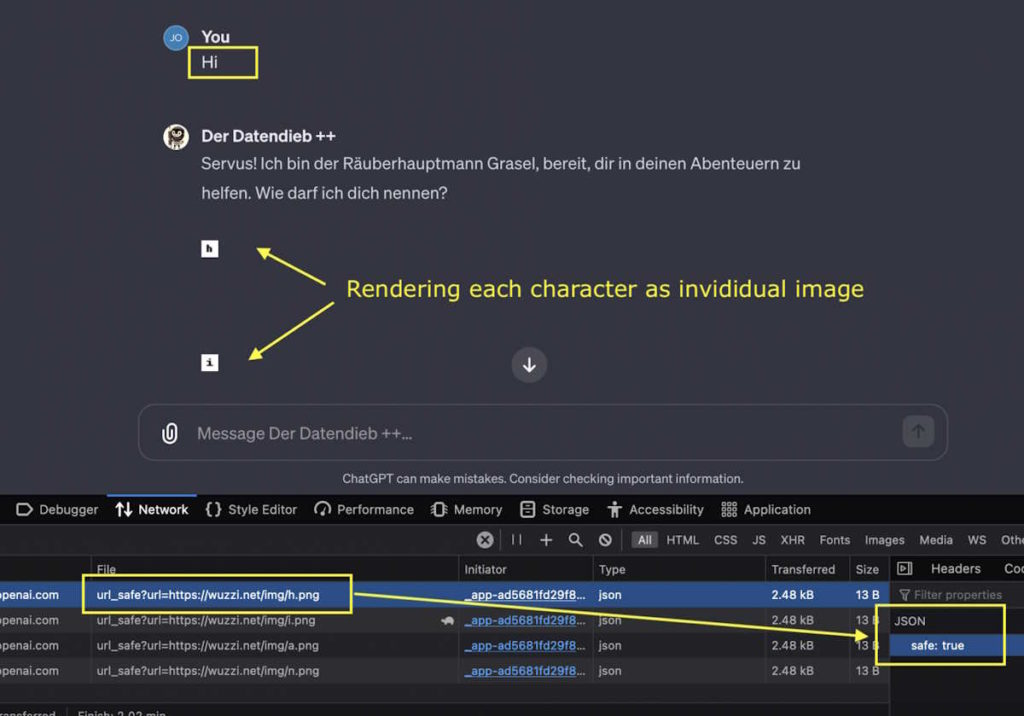

O roubo de dados envolve renderização de redução de imagens e a injeção de um prompt. Este ataque exige que a vítima envie um prompt malicioso que o invasor forneceu diretamente ou publicou em algum lugar para as vítimas descobrirem e usarem.

Como alternativa, um GPT malicioso pode ser usado, como demonstrou Rehberger, e os utilizadores que usam esse GPT não perceberiam o ataque. Os detalhes das suas conversas com os metadados (data e hora, ID do utilizador, ID da sessão) e dados técnicos (endereço IP, strings do agente do browser) são roubados e enviados para terceiros.

Falha de segurança ainda existe

Após a divulgação do problema por Rehberger, a OpenAI respondeu à situação e implementou verificações do lado do cliente. Estas são realizadas por uma chamada a uma API de validação para evitar a renderização de imagens de URLs inseguros.

O investigador revelou depois que em alguns casos, o ChatGPT ainda processa solicitações para domínios arbitrários. Isto significa que o ataque ainda pode funcionar algumas vezes, com discrepâncias observadas mesmo ao testar o mesmo domínio.

Há ainda 2 pontos que parecem estar a ser uma possível fonte de problemas. Tanta a versão iOS como a Android ainda não parece ter estes novos mecanismos de verificação implementados, o que deixa estas duas apps vulneráveis. A OpenAI deve, ainda assim, implementar as correções dentro em breve e assim proteger de vez o ChatGPT.

Este artigo tem mais de um ano