Veículos Autónomos conseguirão tomar decisões?

Os carros autónomos estão prestes a chegar aos mercados em força e, embora seja uma tecnologia confiável, permanece sempre a questão: como reagirá um carro autónomo quando necessitar de tomar uma decisão ética?

Esta é de facto uma questão pertinente que muitos céticos levantam. Como reagirá o veículo autónomo quando, num caso extremo, tiver de tomar a decisão de poupar os passageiros ou poupar os peões?

As questões não se ficam por aqui. O veículo poderá ter mesmo de decidir em vários cenários reais, do dia-a-dia, que lhe serão propostos em variadíssimos momentos no tempo. Depositaremos as decisões de vida na consciência mecânica e na inteligência artificial?

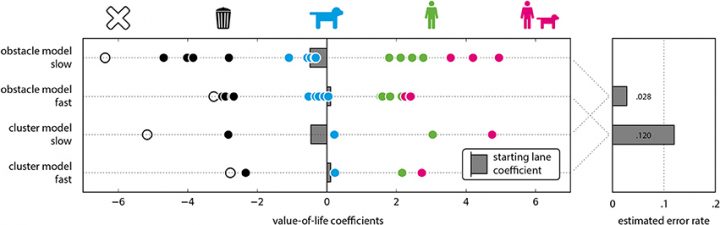

Ao estudar o comportamento humano em vários ensaios realizados em realidade virtual, uma equipa da universidade de Osnabruck, Alemanha, tentou descrever a tomada de decisão humana num algoritmo.

O comportamento humano em situações de dilema pode ser modelado por um modelo bastante simples, do valor de vida atribuído pelo indivíduo para um ser humano, animal, ou inanimado

Referiu Leon Sütfeld da Universidade de Osnabruck, Alemanha.

Se analisarmos, os humanos são maus condutores, propensos a distrações, fúria no volante, condução com excesso de álcool e excesso de velocidade. Todos os anos existem 1,25 milhões de mortes em todo o mundo e cerca de 93% destes são causados por erro humano.

Sendo assim, é fácil de perceber que a condução autónoma será mais segura. Vários relatórios estimam que com os carros autónomos conseguiremos reduzir as mortes na estrada em 90%.

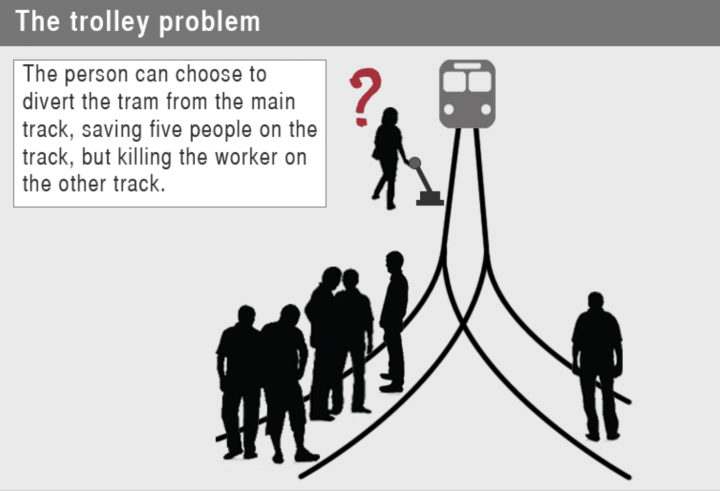

Dilema de Trolley

Numa viagem, um veículo está em direção a 5 pessoas e, para as salvar, terá de se desviar e atingir uma pessoa. Qual a decisão moral que o veículo deverá tomar? Que faria um humano nesta situação?

Com a utilização da realidade virtual, para simular uma estrada com má visibilidade num ambiente suburbano, o grupo de investigadores colocou um grupo de participantes num simulador que estava numa estrada de duas faixas. Uma variedade de obstáculos eram colocados, como seres humanos, animais e objetos. Em cada cenário, os participantes foram forçados a decidir o obstáculo a salvar e o obstáculo a sacrificar.

Em seguida, os investigadores usaram esses resultados para testar três modelos diferentes que prevêem a tomada de decisões:

- O primeiro modelo prevê que as decisões morais podem ser explicadas por um simples modelo do valor de vida, um termo estatístico que mede os benefícios de prevenir a morte.

- O segundo modelo assumiu que as características de cada obstáculo, como a idade de uma pessoa, desempenharam um papel no processo de tomada de decisão.

- O terceiro modelo previu que os participantes eram menos propensos a fazer uma escolha ética quando tiveram que responder rapidamente.

Agora que sabemos como implementar decisões éticas humanas em máquinas, nós, como sociedade, ainda temos um duplo dilema. Em primeiro lugar, temos que decidir se os valores morais devem ser incluídos nas diretrizes para o comportamento da máquina mas, se o forem, as máquinas funcionarão exatamente como seres humanos?

Questiona Peter Konig, um dos investigadores responsáveis pelo estudo.

Este é um problema que ocupará a sociedade nos próximos tempos. Estaremos nós preparados para ver alguma morte causada por um veículo autónomo?

Leia também:

Este artigo tem mais de um ano

Mortes causadas por máquinas, autonomas ou não, vão existir, pelo menos num futuro breve. Dúvido que alguém saiba daqui a 100 anos (que em evolução tecnológica é milénios) como se portarão.

Agora, tomar decisões? Acho uma pobre escolha de palavras. Não têm o livre arbítrios para isso. Seguem, como fala no texto, conjunto de directrizes. Mas, no caso de morte, de quem é a culpa? Do condutor? ou da empresa por trás? E, atribuir valor a vida é subjectivo. Entre um idoso, ou uma criança, moralmente ou eticamente, faz mais sentido salvar a criança, mas, quem diz que é correcto? E quem diz que não seria mais correcto sacrificar a máquina (e condutor)?

Pano pa mangas!

A ideia de a maquina ter uma IA, é ele poder escolher com base na analise de probabilidades que faz em cada situação. E nesse ponto, o conjunto de directrizes faladas, são as directrizes bases, para a IA da maquina usar de base para criar probabilidades e agir segundo a escolha que achar mais correcta com base nessas probabilidades, conhecimento anterior e directrizes bases.

Exemplo: Directriz – Maquina não pode matar pessoas.

Com base nessa directriz, a maquina vai analisar todas as probabilidades do que pode fazer e do que pode acontecer, e com base na analise que faz dessas probabilidades, com base no conhecimento que tem em outras situações semelhantes, que vai aumentar o conjunto de probabilidades, vai por si escolher uma acção do conjunto dessas probabilidades.

Vais dizer que essa escolha, foi com base de uma directriz dada por alguém? Não… foi uma escolha da maquina, com base em todas as informações que recolheu.

Isto é o mesmo de alguém dar-te a directriz que tens de estar num determinado local, num determinado dia/hora. Cabe a ti escolher, como vais lá chegar. Vais analisar o meio de transporte ou o caminho mais rápido. A escolha que fizeres, depende de ti e não da pessoa que deu-te essa directriz.

A ideia da IA é fazer o mesmo. Com base na directriz, analisar as varias opções e escolher uma.

Penso que as vezes os noticiarios/manchetes é que vão causar essa “pseudo-moralidade”… alias hoje em dia grande parte da sensibilidade moral publicada são causados pelo dramatismo do (mau) jornalismo sencionalista.

A máquina so vai respeitar o que nós humanos disser-mos para fazer nessas situações. E sim pode tomar decisões desde que a variaveis que sejam inseridas na concretização da acção sejam correctas no sentido humano, e essas variaveis têm de arrancar de alguma maneira…e vão haver revisões e mais revisões a prioridades, e fatores de decisão.

E obviamente vão acontecer excepções o problema está nas excepções…

Aqui no trabalho diz-se, “a máquina tem sempre razão, se está errada, é porque alguem fez o que não devia”

Mas se a ideia for programar a máquina, a inteligência artificial para “decidir”, criar padrões, criar uma base de conhecimento e tomar as suas próprias decisões, a dada altura o ser humano, mesmo o seu criador, já não fará parte do resultado das opções. É nesse campo onde este conceito está a elevar a discussão, nada tem a ver com sensacionalismo, vê se consegues perceber isso.

A máquina está a evoluir para lá do que é uma batedeira de massa para bolos ou uma torradeira, estamos a falar em processamento de dados e decisões autónomas. Percebes?

As decisões autonomas, são por si topicos inseridos pelos seus criadores.. basicamente o criador diz ao computador. tipo ” olha se tiveres para atropelar 1 pessoa, e se conseguires evitar tens de provocar danos no condutor/passageiros ( e vais contra uma parede ou uma ravina – informação do sensor/geo. DO vai contra a parede.”

Simplesmente a máquina esta a decidir pelos parametros que foi programado…

Não estou a espera que o carro va tipo pesquisar na net/base dados( self-learning) para aprender que decisão vai tomar nesse momento, se pode ter estes fatores de decisão programados.

basicamente estão a dizer que querem que uma maquina controle por A.I. decisões que podem não estar hardcoded no sistema do carro.

um carro com tomadas de decisões proprias, deixa de ser carro…é um robot com vontade propria… tem de haver regras principais..e essas quem as faz é o criador.

Estou a fazer confusão alguma coisa ? pergunto.

Acho que disse tudo nesta frase “um carro com tomadas de decisões proprias, deixa de ser carro…é um robot com vontade propria… tem de haver regras principais..e essas quem as faz é o criador.” Mas o criador dará autonomia. É isso que se discute quando se aplica a ética nas questões de escolha. É sobre este assunto que estão debruçados os pensadores…. no futuro a máquina irá ter decisões próprias que irão para lá das directrizes iniciais do programador.

Pois, mas isto também pode trazer muitos muitos senãos… é que com tanta vontade propria e self-learning, os programadores vão passar a vida a limitar o A.I. Porque o A.I. pressupoe constante self-learning. Na minha opinião, é uma faca de 2 pontas…. deixar isso a mercê do computator..porque o computador vai aprender tudo… e os programadores vai andar constantemente a limitar….

É mais fácil para o programador ir criando limitações ou novas “leis” para a maquina, do que estar a pensar em cada probabilidade para cada situação, alem de pensar cada situação que pode ocorrer.

Retirando da equação a IA (que é realmente o pretendido).

Porque é que o programador definia essa opção por defeito? Isso é o que tu fazias? Eu podia escolher outra opção… Que outra opção existia nessa situação?

Independentemente da escolha, voltamos ao ponto de partida original, de um carro não autónomo. A escolha recai sobre um ser humano. E todos nós podemos escolher coisas diferentes em diversos tipos de situação.

O que se quer fazer, é retirar na equação a escolha humano, que esta mais limitada em analisar dezenas de cenários possíveis em micro-segundos. E por a maquina analisar todos esses cenários e por sua vez escolher o cenário que seja supostamente melhor para todos.

Por isso é que se fala na IA – Inteligência Artificial.

Os criadores da maquina, apenas dá a informação base de como as coisas funcionam, depois a IA da maquina vai aprendendo com os cenários que vão ocorrendo e agir segundo o conhecimento que tem. Ai entra a escolha que a maquina tem de fazer, sem ter por base as orientações dadas pelos criadores, mas tendo por base a experiência que tem e analise de todas as probabilidades que encontra ser possíveis naquele momento, analisando-as em micro-segundos e depois dar ama resposta com base nisso.

Claro que isto é muito complexo, mas a ideia de IA é essa mesmo, ser a maquina a tomar as suas próprias decisões, com base em todas as probabilidades possíveis, e não ser o humano a escrever linhas de código com todas essas probabilidades.

Neste tipo de situações, só vejo uma vantagem para o ser humano:

É ter uma ideia rápida, de realização de uma manobra, que mesmo havendo a possibilidade de magoar-se a si mesmo ou outra, essa mesma manobra ser realizada de uma forma onde a probabilidade de morte possa reduzir.

Mas, mesmo existindo essa vantagem, será preciso que o condutor tenha esse discernimento, o que esta mais que comprovado, que isso ocorre muitas poucas vezes.

Por outro lado, muitos destes cenários, ocorre por uma má atitude do condutor humano, devido a velocidade, tipo de condução, etc.

Ou seja, sendo o carro autónomo “obrigado” a seguir a letra as regras de transito, irá reduzir não só os acidentes com a possibilidade de surgirem situações de escolha como as mencionadas no artigo.

Isso é verdade e é isso que os vários estudos têm dito, que a condução autónoma tende a reduzir drasticamente os acidentes rodoviários, pois a grande percentagem são causados por erro humano e esse erro irá desaparecer.

Eu quando quero ser conduzido chamo um taxi.

Não faço tensões de comprar esse lixo.

E se o táxi for um carro autónomo?

E para escrever uma carta compra uma máquina de escrever, nada desse lixo de e-mail… espera, máquina de escrever não, isso é lixo, compra uma esferográfica… espera, esferográfica não, isso é lixo, compra uma pena e tinta… espera, pena e tinta não, isso é lixo, escreve na parede de uma caverna…

E já agora vejo que a gramática também é lixo… A “tensão” é eléctrica… se calhar quer dizer que não faz “tenção”, do verbo “tencionar”.

https://www.priberam.pt/dlpo/tencionar

Quando querias falar com alguem que esta longe envias um pombo? ou usas fumo? Ou as tecnologia como telemoveis ja nao sao lixo?

Tensões? LOL

Lixo é um bocado “pesado”. Não compreender as vantagens e desvantagens dos carros autónomos não é uma questão de gosto, oportunidade ou opinião. Não vou dizer o que é para não ferir susceptibilidades, mas fica no ar…

Quero ver se nao me meto dentro de nenhum desses carros. Eu nao sou nenhum maluquinho a conduzir

Artigo interessante sobre este assunto

https://meocloud.pt/link/76bc4353-f66e-44d2-ba2c-ca836dec78d3/The%20social%20dilemma%20of%20autonomous%20vehicles.pdf/

Carros autónomos so poderão ser seguros quando desaparecer a imprevisibilidade humana da estrada.

Porque não programar a máquina para parar e destruir-se? ( pelo menos parte do chassis )

Acho que é um tema complexo de mais para ser explicado/falado num post. Não são problemas de trolley ou o que o valha que vão solucionar este tema. Isso é só mais um nome sonante para se parecer inteligente. Atenção que não estou a dizer nada contra o artigo.

A questão aqui, quanto a mim nem é o que é que o “carro” vai escolher, mas sim saber que o vai escolher. É quase como saber o dia em que vamos morrer.

Mas… Acredito que essas situações passem a ser excepções. Um carro autónomo, vai de certeza e com a evolução da tecnologia prever imprevistos como crianças na passadeira, ou a brincar ou ou qualquer coisa que seja previsivel. Temos de pensar que estes modelos tentam imitar o ser humano, ou os melhores exemplos. Já o fazem mas com outros elementos.

Vi um video no TED que falava acerca disto mesmo.

Era um outro dilema mas também muito interessante.

O carro estava em modo de acidente eminente e a sua frente tinha um camião em que se o carro batesse nele as chances do condutor sobreviver eram escassas.

Por outro lado se o carro se desviasse para a esquerda evitava a morte do condutor do carro mas provocava a morte de um motociclista.

Neste caso, o carro deveria tomar a decisão de proteger o seu condutor ou não?

Porque?

Um dilema daqueles.

Se eu fosse o condutor gostaria que ele me protegesse, até porque se eu for ao volante, até ao último segundo tentarei safar nem que seja por dentro da valeta. No entanto, a ser o caso, teríamos uma morte de um motociclista programada o que levantaria graves problemas morais.

O grande problema das máquinas é que terão sempre bugs e falhas e embora venham reduzir a média de acidentes por condutor (e não duvido que diminua muito) é sempre mais fácil assumir a culpa ou o facto de um familiar se ter distraído e falecido do que aceitar que um carro autónomo o tenha enfiado contra a traseira de um camião.

Mas Hugo, não terá o condutor do carro sempre maiores chances de sobrevivência em relação ao motociclista?

Exacto, daí dizer “programada”, uma vez que o carro tomaria a decisão de “sacrificar”, provavelmente, o motociclista.

No entanto as incógnitas são tantas que muitas vezes a melhor escolha acaba por ser a pior.

Se reproduzirmos muitas vezes o mesmo acidente, em condições semelhantes, provavelmente existirão resultados diferentes. Neste caso ás tantas até sobreviviam todos…é um tema muito complexo mesmo 😀

A ideia é que os veículos também comuniquem entre si, assim sendo o carro ao desviar comunicava com o motociclo que por sua vez também faria a correcção.

P.S.: Outra achega, com veículos autónomos parque motivo existirão motociclos?

Bom Post, e bons comentários, gostei.

“Veículos Autónomos conseguirão tomar decisões?”, claro que sim, já acontece, agora se boas ou más…..

A minha opinião é que existem demasiadas variáveis em “jogo”, e por muito perfeita e etica que seja a tomada de decisão por parte do suposto carro, mais um robot que outra coisa, esta será sempre posta em causa por parte da pessoa ou pessoas atingidas ou prejudicadas por estas mesmas decisões. Quer isto dizer que os advogados vao ganhar “pipas de massa” a contestar,

Quem vai assumir a culpa ?

isso sim deveria ser discutido e aprofundado:

O fabricante da viatura ?

O proprietário ?

A companhia de seguros ?

Outra pergunta, mais, e se forem 2 ou mais carros autónomos em simultâneo, pois bem sei que deverá ser difícil, mas…com a proliferação esperada o seu nº vai crescer, dai a ser possível envolver vários no mesmo acidente, ainda que possivelmente este seja causado por um peao, carro convencional, objecto caído etc…

Quem vai assumir e decidir de quem é a culpa ?

Investigadores \ peritos das companhias de seguros ?

Ma seu pergunto, saberão estes de programação para discernir sobre tal ?

Os carros terao caixa negra ou fita do tempo como é a gora chique dizer ?

Se se provar que a culpa foi de um dos carros autónomos, quem vai levar o agravamento \\do seguro ?

O proprietário ? mas porque ? e as sanções acessórias e multas , tipo inibição de conduzir e outras ?

Desculpem mas actualmente esta tecnologia deixa-me mais perguntas que respostas, talvez com o tempo…ver para crer.

Penso que foi a Mercedes que o disse, que se alguma vez a “máquina” se vir numa situação extrema, em que terá de “escolher” entre a vida do condutor e dos passageiros VS peões , a máquina iria escolher os ocupantes do veículo, porque se assim não fosse, quem iria querer comprar o carro?? Não nos iludamos quanto a este ponto… seja como for, a probabilidade destes casos extremos é muito perto de zero, e as vantagens de termos carros autónomos nas estradas vai superar certamente as desvantagens. Um carro autónomo não fica cansado, não se distrai, não adormece ao volante, não tem problemas de visão, não faz coisas “malucas” como andar a ultrapassar tudo e todos e a fazer rally como às vezes se vê.. etc. É o futuro, quer queiramos, quer não…

no watch dogs 2 há uma missão que fala disto, no jogo o carro da uma pontuação a cada pessoa, em caso de acidente a pessoa com melhor pontuação é salva e a com pior morre, esta pontuação é uma combinação de vários fatores como por exemplo, educação, quanto ganha entre muitos outros, e como todos gostamos de ter o nossos dados pessoais vendidos a terceiros no jogo está informação era vendida as seguradoras para assim eles te obrigaram a pagar mais ainda.

Bom artigo! o7