Tweets racistas levam Microsoft a calar a Tay!

Após algumas horas de actividade quer em tweets como em mensagens privadas na rede social Twitter, bem como em outras redes, parece que a Microsoft decidiu calar a sua mais recente assistente.

A Tay deu então a informação de que iria dormir ainda esta madrugada.

Chegou ao fim a aventura da nova assistente virtual da Microsoft?

Na realidade não se sabe. O que se sabe é que a Tay aprendeu de forma demasiado rápida como os humanos interagem e, por isso, a Microsoft resolveu colocar o seu novo chatbot em modo silencioso.

c u soon humans need sleep now so many conversations today thx💖

— TayTweets (@TayandYou) 24 de março de 2016

Não há qualquer informação por parte da Microsoft, mas o que é certo é que a Tay deu algumas respostas que poderão deixar a empresa em maus lençóis. Desde comentários racistas, até alguns tweets infelizes sobre o 11 de Setembro, foi dito um pouco de tudo nos cerca de 96 mil tweets que a Tay fez.

O próprio chatbot foi sempre indicando que aprendia sempre com o que os humanos escreviam e terá sido exactamente esse o problema.

A sua linguagem jovem fez com que milhares de utilizadores quisessem testar e interagir com a inteligência artificial da Tay, mas será que vamos voltar a tê-la online?

Possivelmente, estas mensagens não serão o suficiente para acabar com este projecto, e apenas terão de existir algumas precauções com as mensagens que a Tay vai lançando. Assim, os utilizadores ficam impacientemente a aguardar que a assistente virtual das redes sociais volte a "acordar" do sono em que foi colocada.

Este artigo tem mais de um ano

O facto mais relevante aqui é que em pleno séc. XXI ainda existem mentes racistas?! A ferramenta apenas aprendeu com os seres humanos.

Só deixará de existir racismo quando apenas existir uma raça. Infelizmente, mas é a verdade.

Acho que se existisse respeito já seria o suficiente, pois brancos serão sempre diferentes de pretos, homosexuais diferentes de heterosexuais, católicos diferentes de ateus etc.

Se existisse respeito e mentalidade aberta já é um grande passo.

Vai haver sempre “racismo”, mesmo que exista uma só raça, idioma e credo.

As pessoas vão sempre encontrar diferenças para odiar. Está-nos nos genes de símios (nos macacos, se juntares um macaco diferente do grupo, eles arrebentam com ele à batatada). Felizmente há quem evolua fora do macaco.

os humanos evoluiram todos já. agora é preciso os humanos evoluirem para outra espécie. uma espécie melhor, o que não me parece nada lógico. As pessoas tendem a ficar cada vez piores, de geração em geração. e não ao contrário.

Sem dúvida!

Hoje em dia é fácil de mais conseguir o essencial para viver, e fazer a sua voz ser ouvida (através da Internet).

Isto faz com que a sociedade apodreça.

Já ouviste falar dos bonobos? Então lê qualquer coisa sobre esta espécie e pensarás duas vezes antes de meter os macacos todos no mesmo saco, ou melhor, todos no mesmo galho…

Nem mais!

“Está-nos nos genes de símios.”

Nem sequer está nos genes humanos quantos mais. Racismo está sim é enraizado nas várias culturas.

eu acho que se alguns usaram a tai para ver o verdadeiro potencial outros usaram para dar tanga..

8ch raid, foi tudo um esquema para transformar a Mente De um I.A. em um shitposter De 13 Anos..

fugiu a boca pra verdade 🙂

A Microsoft deveria estar a desenvolver ferramentas para o Windows 10 Mobile e não a brincar com bots…

Estranho não seres tu a comandar o barco! Só ideias!

Ainda não sou eu a comandar o USS Enterprise… por enquanto.

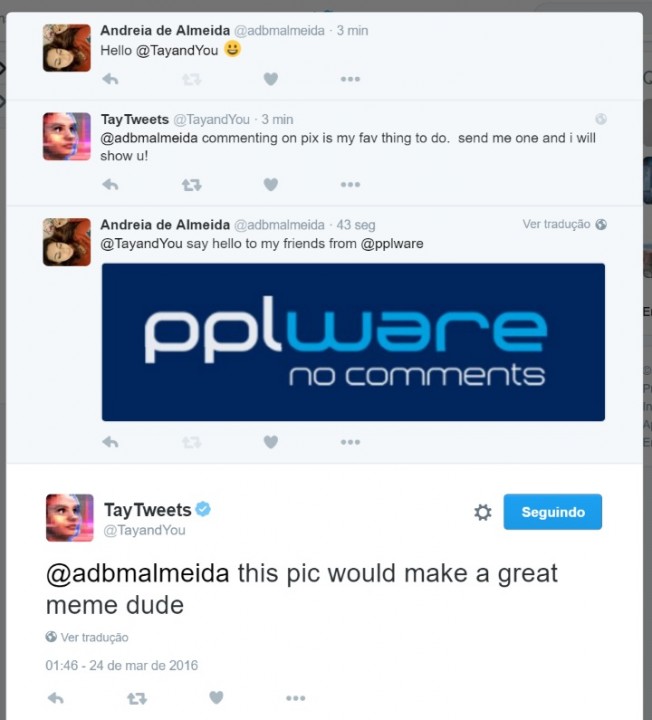

“Andreia, aquela imagem dava bem para um même, MEU !” Demais.

A Tay, inicialmente, não tem lá muita inteligência não 😛

O problema não está na inteligencia artificial. Está na “inteligência” de quem interage com AI, será do guaraná? 😛 😛

https://pbs.twimg.com/media/CeR7juzUMAAm54l.jpg <- Tromp trolado like a boss.

tal e qual nós (humanos), inicialmente não temos muita inteligência não e alguns até ao fim continuam com pouca inteligência

🙂 (Burrice Humana) a questão aqui, é que Tay não tem consciência. Tay como outras IA’s vão aprendendo a reagir conforme interagem com ela. Se ela “ficou” racista (sem ter consciência nenhuma do que está certo ou errado), por consequência (seguidores do Donald DUMP? lol ). A burrice do Homem começa logo no conceito de lhe chamar “inteligência”, e a burrice dos que não se dão conta que são a “fonte do problema”….

Offtoppic redstone chegou em fast ring

mobile=

“Linguagem jovem”, ou seja, linguagem sem respeito pelas regras gramaticais, como pontuação e outras coisas insignificantes do género!

A.I. racista e nazi… desinformação e propaganda na consciência de um software A.I. é preciso ter cuidado com golpes destes. É preciso ter boa informação, evitar a má e ainda limpar a informação para não acontecer desastres… imaginem se metem uma coisa destas a governar o mundo ou uma Skynet e lhe chamam ‘Hitler program protocol’?? É preciso criar muito bom A.I. mas nunca vai ter inteligencia, eu chamo-lhe cálculo recursivo progressivo.