WinContig 1.00 RC 2 – Arrumar um pouco mais a casa

WinContig é uma simples ferramenta de desfragmentação que, sem instalar qualquer linha no seu computador, o ajudará a manter o sistema limpo.

A intenção é ter este programa numa penUSB e em casos de SOS numa máquina qualquer, poder começar o tratamento de cura com uma desfragmentação ao disco.

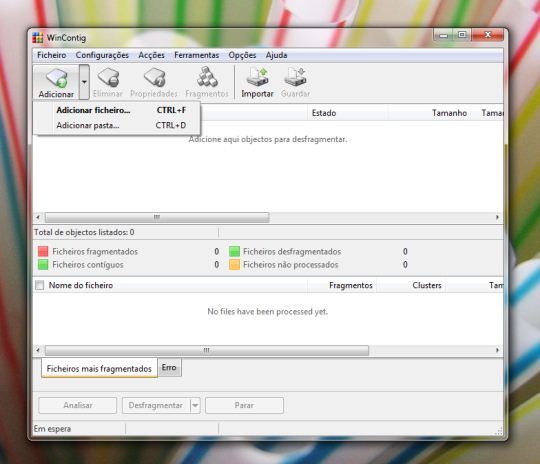

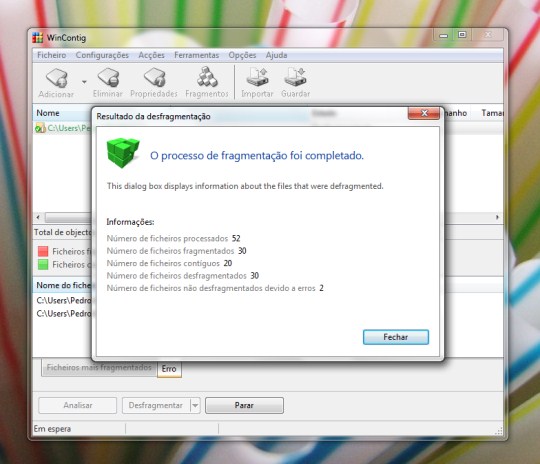

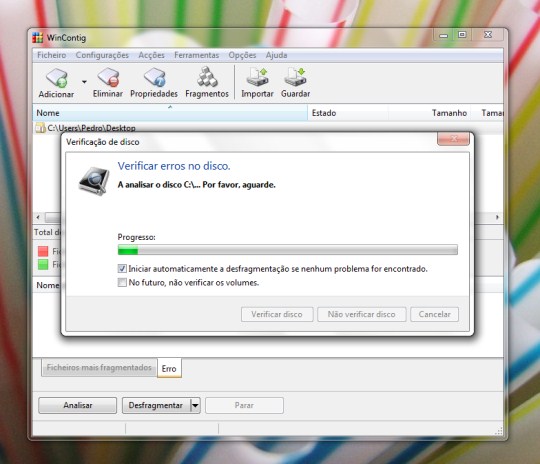

Como não precisamos de desfragmentar o disco de fio a pavio, esta ferramenta permite escolher ficheiros ou pastas, onde estejam contidos grandes quantidades de dados, começando por aí a desfragmentação. Passo-a-passo, o disco estará mais compacto e liberto de fragmentos espalhados nos sectores errados.

Adicionalmente, WinContig permite reunir num perfil um grupo de ficheiros, aqueles que normalmente todos os dias sofrem alterações.

Enfim, é muito simples e poderoso este programa! Não tem grande expressão em termos de consumo, é rápido a varrer o disco na procura dos "pedaços" dos ficheiros fragmentados. Pode alterar diversas opções das aplicações tornando o processo mais próximo das suas necessidades.

Pode utilizar esta aplicação para fins comerciais. O autor não o limita a uso não profissional. Tenha direitos de administrador para executar esta ferramenta.

![]() Licença: Freeware

Licença: Freeware

![]() Sistemas Operativos: Windows 2K/ XP/Vista/ 7

Sistemas Operativos: Windows 2K/ XP/Vista/ 7

![]() Download: WinContig 1 RC2 [784.89KB]

Download: WinContig 1 RC2 [784.89KB]

![]() Homepage: WinContig

Homepage: WinContig

Este artigo tem mais de um ano

Interessante, super leve

O tipo de utilitários que eu chamo de “Disk Assassin”.

O tipo de pessoa que não se argumenta quando faz uma afirmação…

Pode ser o tipo de pessoa que não tem tempo de explicar o óbvio, mas vai tentar:

Os ganhos de performance num disco com os ficheiros “alinhados” fisicamente é ínfima comparando com um disco com os ficheiros desfragmentados de acordo com o método de escrita do S.O. (sistemas de ficheiros como NTFS são suficientemente inteligentes para colocarem os blocos em locais o mais próximo uns dos outros e o menos fragmentados).

Se tivermos em conta que todos os discos têm uma vida útil, a cada desfragmentação, que pode demorar muitas horas ou DIAS, dependendo do “caos” e do numero de ficheiros, o desgaste é quanto a mim, equivalente a semanas ou MESES de utilização normal (visto a desfragmentação ser um processo INTENSIVO de leitura e escrita, complicado pelo facto de, quanto menos espaço estiver disponível em disco, mais operações de leitura / escrita vão ser efectuadas, SISTEMÁTICAMENTE sobre um mesmo local, que é o local disponível para a deslocação dos ficheiros temporáriamente).

Evidentemente que, se o disco tiver 10% da sua capacidade ocupada, com meia dúzia de files de alguns GIGAS, a desfragmentação será um processo quase irrelevante…

A durabilidade de um disco não é a prioridade para todos, a performance pode ser mais importante. E aí desculpa discordar por completo, mas no parque informático com que trabalho sempre que faço a desfragmentação em determinadas máquinas nem parecem as mesmas!! Ficam com um desempenho completamente diferente!!

A maior parte de falências em disco devem-se a falhas mecânicas. As próprias marcas de discos admitem que a garantia é baseada neste tipo de falha.

Em termos de discos (NÃO SSD) a única garantia que temos é que “quanto maior o uso, maior a probabilidade de ocorrer um erro”.

Existem situações em que alinhar fisicamente ficheiros em disco se “ganha” tempo de vida do disco ao diminuir o tempo de acesso a ficheiro especialmente de modo recorrente. Ficarias surpreso com exemplos profissionais que já me passaram pelas mãos.

Em termos de conclusão:

1- Desfragmentar constantemente um disco é irrelevante

2- Sugiro que em vez de seres condescendente com as pessoas que seguem este forum em busca de conhecimento, exponhas e partilhes o teu de forma útil

😉

“Existem situações em que alinhar fisicamente ficheiros em disco se “ganha” tempo de vida do disco ao diminuir o tempo de acesso a ficheiro especialmente de modo recorrente.”

Podes exemplificar essas situacoes?

Sabes que durante a operacao de um sistema operativo, existem varias aplicacoes que num curto periodo de tempo pedem determinados ficheiros que nao se encontram de forma sequencial, e que obrigam a que o disco faca varios saltos?

Que as aplicacoes normalmente nao requerem o conteudo de um ficheiro na sua totalidade? E mesmo que o ficheiro esteja continuo, nao significa que o SO nao pare o disco e peca o conteudo de um ficheiro num sector completamento oposto, para responder a um pedido de outra aplicacao.

Que o sistema operativo pode aceder a dois ficheiros que estejam na mesma directoria, no entanto, os seus conteudos estao extremamente separados?

Mesmo que tenhas um ficheiro logicamente continuo, nao significa que isso aconteca fisicamente (CHS: cilindro, cabeca, sector).

Qual seria o impacto disso?

Existem mais variaveis para a performance dos acesso ao disco do que a simples fragmentacao de um ficheiro no disco. A fragmentacao e’ a menor delas todas.

E muitos tambem notam uma diferenca na performance do SO quando alteram valores a chaves do Registo do Windows que leram numa dica, para meses depois os programadores do Windows virem dizer que o SO nao faz uso dessas chaves para nada (e isto acontece depois de ficarem fartos de terem que explicar porque nao colocam esses valores por defeito).

“Ficarias surpreso com exemplos profissionais que já me passaram pelas mãos.”

Sempre podes dar esses exemplos.

Fiquem Bem!

Podes dar as voltas que quiseres ao tema no entanto quer em termos de velocidade de leitura/acesso ou durabilidade do disco está tudo ligado ao mesmo factor:

-Redução do movimento do braço de disco.

A última vez que vi a gravação num disco era efectuada por faixa e de fora para dentro…

Pega num disco ao fim de um ano de utilização banal de qualquer pessoa, faz uma desfragmentção e depois vem falar comigo.

Aquele abraço

Os que falam que a fragmentacao e’ muito importante nunca dao exemplos (a nao ser completamente abstractos), nao conhecem como o sistema oeprativo funciona, nem como este vai buscar informacao ao disco, como as aplicacoes acedem os ficheiros, etc. Mas sabem que e’ tudo devido ‘a fragmentacao.

No Windows, para alguns, que ainda acham que usam a FAT, e’ preciso desfragmentar para manter uma boa resposta do sistema operativo; no Linux, nao e’ preciso. No entanto, tanto o NTFS e ext2 (ext3 e ext4) usam as mesmas tecnicas para a fragmentacao nao ser um problema na vasta maioria dos casos.

E ja’ fiz esses testes e nao houve nenhuma alteracao. Tambem usei disco estremamente fragmentados, e o impacto e’ nulo, porque depende do que estas a fazer.

O meu comentario foi para que tu desses exemplos especificos, tendo em conta a tua experiencia, e desconversaste.

Fiquem Bem!

Sem concordar imediatamente com o Marco Lopes gostaria apenas de salientar é que muito arriscado mandar uma aplicação “qualquer” reecrever todas a nossa informação no disco.

Muita coisa pode correr mal, ficheiros corrompidos, directorias vazias, etc. É verdade que os algoritmos evoluiram muito e que os discos também mas… nunca fiando!

Não digo que assassinará o disco mas eu aconselho cautela aos mais entusiastas; testem tudo em informação dispensável para evitar surpresas desagradáveis

Caro Trimegisto,

Já nem foco a questão da “perda de dados”. Já tive o mau hábito de desfragmentar discos e quando penso que o fazia sem uma UPS no sistema… Concordo com a qualidade dos desfragmentadores, mesmo as primeiras versões que utilizei, ainda em MS-DOS (NORTON) eram eficientes. A questão aqui é o custo / benefício e claramente este é um daqueles processos equivalentes a correr a meia maratona apenas por gosto. Se tivermos em conta que o disco não necessita de exercício físico, e quanto mais quietinho estiver, mais horas de vida terá, não vejo onde está o benefício de um aumento de performance quase inmesurável em termos prácticos de utilização normal.

No tempo do MS-DOS e Windows 95/ME, usava-se a FAT, que e’ um sistema de ficheiros que nao sabe que blocos estao ocupados ou livres (o que obriga-o a ler blocos que acaba por determinar que estao ocupados), nao sabe onde se encontra, por exemplo, o decimo bloco de um ficheiro (para isso precisa ler os primeiros 9 blocos para saber onde se encontra o decimo, porque o primeiro bloco aponta para o segundo, …, o nono para o decimo), se a aplicacao apenas precisa adicionar dados ao final do ficheiro, a FAT tem que ler o ficheiro todo para encontrar o ultimo bloco. Se nao sabe onde os ficheiros se encontra, etc. E’ nestas operacoes que a fragmentacao aumenta (consideravalmente) os acessos ao disco e podem atrasar o sistema operativo.

O Windows XP/VISTA/7 usam o NTFS. Este sistema de ficheiros sabe que blocos estao ocupados e livres, usando o BITMAP (um bit representa um bloco em disco). Por exemplo, um disco de 250GB usa por volta de 2 megas para o BITMAP. Se precisar de criar um ficheiro de 1GB, torna-se simples para o NTFS encontrar o melhor local, mesmo que o disco esteja bastante ocupado. Tambem nao precisa de ler blocos no disco para saber onde se encontra o decimo bloco, ou o ultimo bloco do ficheiro.

A partir do Vista, o desfragmentador (GUI) deixou de considerar como fragmentado um ficheiro que tenha blocos continuos superiores a 64megas. E’ uma perca de recursos desfragmentar acima desse valor.

Tenho uma particao com o XP com 22% de fragmentacao, tem menos de 2GB de espaco livre e responde bem. Porque nao deveria?! A maioria da fragmentacao e’ devida a ficheiros de videos com mais de 100megas, musica, ISOs de 700megas cada, etc. Estranharia se esses ficheiros criassem algum impacto no SO.

Fiquem Bem!

Duvido que existe algum problema em corromper informacao, mais do que o proprio NTFS o fazer, porque “quem” faz a desframentacao e’ sempre o Sistema Operativo, mais propriamente, o API de Desfragmentacao de Windows. As aplicacoes, tal como esta, fazem uso do API para evitarem esses problemas.

Fiquem Bem!

Estamos de acordo no geral, embora o assunto da arrumação de ficheiros feita pelo SO, como penso que saiba, seja um assunto muito vasto. No entanto este não deverá ser o espaço indicado para um debate acerca das características da alocação contígua, ligada

ou indexada nem das técnicas best-fit, first-fit e worst-fit.

A verdade é que a desfragmentação, como diz e muito bem, não produz os efeitos milagrosos anunciados, desgasta o hardware e pode ser uma operação arriscada.

Já para não falar nos incautos que perdem tempo a desfragmentar discos SSD… isso fica para outra resposta 🙂

Bom fim de semana!

ah sim… SSD é uma história completamente diferente. Mas eu resumo tanto um caso, como outro da seguinte forma:

Se não está estragado, NÃO MEXAS.

Abraço.